Pulsa aquí para ver la versión en Español (ES)

Abstract

At the end of the first decade of the 21st century, the rapid growth in the MOOC offering brought about a new educational landscape, posing new challenges to teaching and learning, mainly due to massive participation, ubiquity and free enrollment. These courses embody a confluence of technological and pedagogical mediations yet to be fully explored. This study, applying an instrument of educational and interactive indicators on a MOOC (INdiMOOC-EdI) designed by the authors, seeks to ascertain the pedagogical components of MOOCs delivered in the Spanish language in order to establish which course features are platform dependent. An exploratory sequential mixed methods study was carried out on a total of 117 courses within 10 different platforms via an instrument developed and validated ad hoc. The data obtained is subjected to a content analysis for a qualitative perspective; while a quantitative perspective is obtained through a statistical analysis complemented with classification algorithms typical in data mining. The results suggest that the different platform providers condition the pedagogical design of the MOOC in five key areas: learning, activities and tasks, means and resources, interactivity and assessment. It concludes with a series of descriptive, educational and interactive indicators that can be a pedagogical benchmark for future MOOCs.

1. Introduction

MOOCs are a phenomenon of utmost interest to the scientific community due to their exponential growth (Liyanagunawardena, Adams & Williams, 2013; Martinez, Rodriguez & Garcia, 2014; Yuan & Powell, 2013). These courses are a worldwide expanding phenomenon and offer a clear example of disruption (Anderson & McGreal, 2012; Conole, 2013; Vázquez Cano-Lopez & Sarasola, 2013) due to low fees for participants, massive participation and their adaptation to new social needs regarding education. Hence, the disruptive nature of MOOCs can only be verified if taken as experiments to test new methodology, technology and new ways to organize education (Pernías & Lujan-Mora, 2013).

From a pedagogical point of view, the phenomenon can be seen as an ‘effervescence’ rather than a disruption (Roig, Mengual-Andrés & Suarez, 2014), which must not blind us to the reactions they stir. These courses are hosted by varied and diverse platforms, with different backgrounds and approaches which have given rise to MOOCs based on: web-based instruction, the Connectivist Theory and its pedagogical model (Siemens, 2005); tasks, according to competency-based accomplishments (Cormier & Siemens, 2010) and content (Pernías & Lujan-Mora, 2013; Vázquez-Cano, 2013).

Since the inception of MOOCs, the majority of studies have focused mainly on their concept and history of MOOCs; debating the challenges, possibilities and threats thereof; presenting case studies by examining one or more platforms and courses, and reflecting on student participation (Liyanagunawardena & al., 2013). Thereafter, the focus shifted mainly to the completion rates and course quality per se (Baxter & Haycock, 2014; Halawa, Greene & Mitchell, 2014; Jordan, 2014; Koutropoulos & al., 2012; Rodríguez, 2012) and their pedagogical principles (Glance, Forsey & Riley, 2013; Roig & al., 2014; Vázquez-Cano & al., 2013; Zapata, 2013); design and key components are scarcely addressed.

Despite the lack of consensus on how quality standards should be attained in MOOCs (Haggard, 2013), it is necessary to raise the issue in order to prevent MOOCs from becoming «poor quality video watching sessions of chatting professors which are the basis for a set of self-assessment questions and awarding certificates without prior authentication and no other concern except generating revenue» (Aguaded, 2013: 7-8).

It is therefore important to address what pre-course information is provided, the pedagogical approaches underlying the design, the level of student engagement, the role of course instructors, availability and degree of interaction, resource typology as well as certification structure and process (Vázquez-Cano, 2013; Zapata, 2013).

Research on these training approaches shows that they are founded on a decentralized control over teaching-learning processes (Baggaley, 2014). However, given the accessibility and reach of MOOCs there is almost by definition a wide spectrum of users with a variety of interests and motivations, approaches and learning styles; hence, one of the most difficult challenges is to provide authentic learning experiences, which require the design and development of interactive collaborative processes. Siemens (2005) states that cooperative and collaborative activities as well as interaction with technological resources have a direct impact on students, especially on the way they perceive and process information and on their learning process, thus prompting a new knowledge building approach. Given massive student participation the level of interactivity is addressed through the use of specific Web 2.0 collaborative and communicative tools: chat rooms and forums (Baxter & Haycock, 2014) to discuss concerns and share solutions; blogs, wiki-forums and social networks (Medina-Salguero & Aguaded, 2014), among others, for support and feedback.

Assessment normally conforms to final and summative processes that are determined by the type of accreditation awarded once the MOOCs has been successfully completed. In some cases, the objectives are small-scale goals carried out individually or in pairs which are assessed by means of surveys, questionnaires, quizzes, exams, problem sets and other processes that will automatically generate badges as evidence of learning.

In short, studies have focused on the characteristics of the platform providers and the success or failure of a given course (Fini, 2009) and less on the pedagogical aspects. If we want to maximize learning via analyzing and adapting teaching strategies to individuals, we must critically address the pedagogical design of the MOOCs to identify underlying trends in teaching and learning processes. On the basis of the aforementioned, the objectives of this research are:

•To analyze Spanish-language MOOC offering during a given period in order to establish a profile of the pedagogical components.

• To validate a tool that can guide the pedagogical design of MOOCs.

• To ascertain which components are unique to a MOOC from those dependent on the platform.

• To determine whether the pedagogical components of MOOCs are conditioned by platforms.

2. Material and methods

The purpose of this research1 is descriptive with an exploratory sequential mixed-methods design (DEXPLOS) (Creswell, Plano, Gutmann & Hanson, 2008; Hernández, Fernández & Baptista, 2010). This design involves an initial phase of qualitative data gathering and analysis followed by another where quantitative data is collected and analyzed, subsequently, we generate another database that integrates both and enables mixture analysis techniques (García, 2011).

Sequential and criteria sampling (McMillan & Schumacher, 2005) for mixed methods (Hernández & al., 2010) is used. The courses were selected according to the following criteria: catalogued in the repository www.MOOC.es; delivered in Spanish; course information available without prior registration; and provide a minimum amount of information to the data collecting instrument.

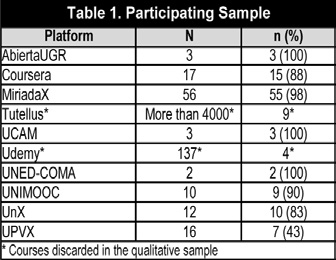

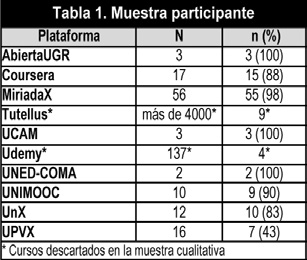

We therefore focus on ten platforms (Open UGR, Coursera, MiriadaX, Tutellus, Ucam, Udemy, UnedComa, UniMOOC, UNX, UPVX. We discarded Ehusfera (a blog hosting service rather than a MOOC platform) Iversity, CourseSites and edX, among others, given that the reference language is not Spanish. This involved analyzing 117 courses from different fields of knowledge available during the month of March 2014 (table 1). The low percentage of courses from Tutellus and Udemy is mainly due to two factors:

• They included material that did not conform to the MOOC concept, such as conferences, videoconferences or lectures on videos, recycled from different sources within the audiovisual repository of the institution and now offered as massive courses.

• They provided very limited information to the research instrument without prior registration. Moreover, there was redundant information on how to use the platform and on certification. It was also noted that there was a high degree of repetition, such that regardless of the course, the data provided was the same.

Consequently, these two platforms were not included in the qualitative sample. Thus, we can state that the remaining 104 courses represent 81.25% of the population.

2.1. Instrument

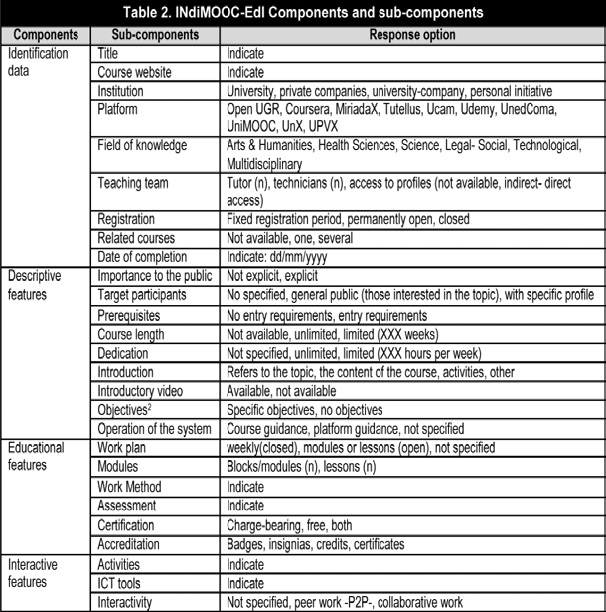

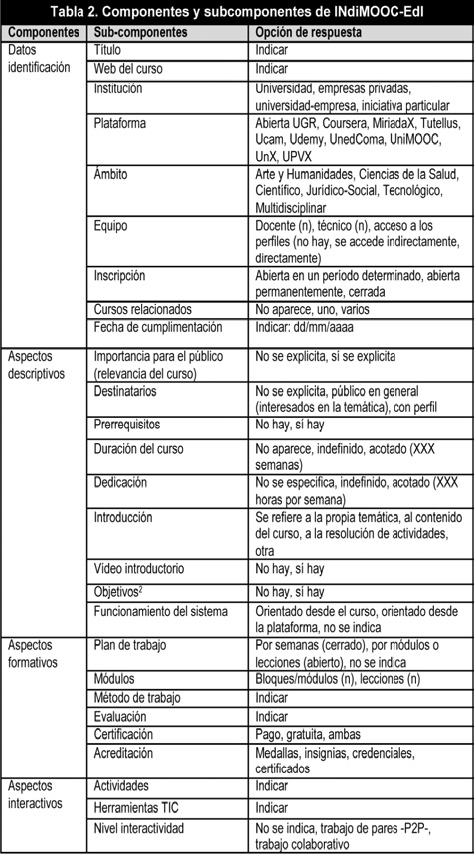

For massive course analysis we developed INdiMOOC-EdI (Instrument for Educational and Interactive Indicators in MOOCs). It is an ad hoc data sheet that meticulously collects information provided in the full description of MOOCs. The elements that make up this instrument can be organized into four components, with a total of 27 sub-components rated on various scales (table 2).

To safeguard validity conditions, the first version of the instrument was subjected to the Delphi technique by evaluating the same courses during the same period of time and a pilot study of 15 courses within 5 different platforms. The expert panel (KC) index rated .75, while content validity (IVC) rated .99 which according to Lawshe (1975) is within the standard satisfactory level. Reliability and internal consistency were determined by Cronbach´s Alpha statistic after the sample gathering procedure i.e., once questions whose answers were measured on an interval scale were eliminated. The 117 courses obtained an alpha value of. 614. Some authors (Huh, Delorme & Reid, 2006; Nunnally, 1967) indicate that an alpha value between .5 and .6 is within the satisfactory standard in the early stages of research or in an exploratory study such as this one. This statistic combines the correlation coefficient of the items that make up the instrument and its dimensionality (Cortina, 1993).

3. Analysis and results

A descriptive analysis of quantitative data was carried out according to the identifiers and descriptive features displayed in table 2, together with a categorical principal component analysis that enables a large set of variables to be grouped in a smaller number of explanatory components that stem from the variance among the original data.

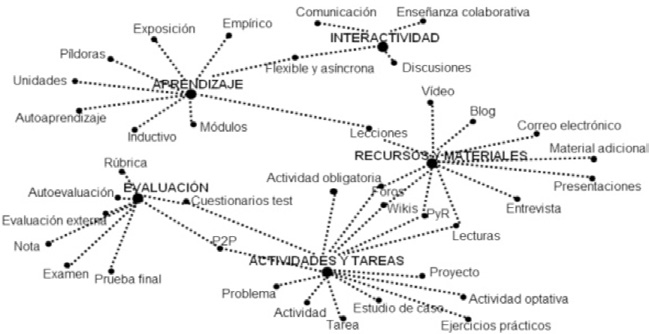

With the qualitative data (interactive and educational features) we conducted a content analysis that deployed five major categories:

• Learning: styles, learning modality taking place and content format: self-directed learning, empirical and inductive learning, learning through observation; lessons, units, pills or modules.

• Activities and tasks: refers to both modality (compulsory or optional, individual or collective) and typology (questionnaires, tests, readings, practical exercises, problem sets, projects, case studies, questions and answers, participation…).

• Means and resources: traditional and technology-based: videos, slideshows, forums, blogs, wikis, e-mails, interviews, readings, optional additional material.

• Interactivity: or interacting with other people; online meetings, debates or discussions in pairs or groups, sharing doubts and knowledge, collaborative work, flexible and asynchronous communication.

• Assessment: existing assessment procedure, not only modalities and instruments, but also grades and endorsement (self-assessment, peer assessment; questionnaires, tests, rubrics, exams, problem solving, –peertopeer); percentage or weighting in the final grade, grading scale, passing grade, minimum percentage; checking student progress and final endorsement.

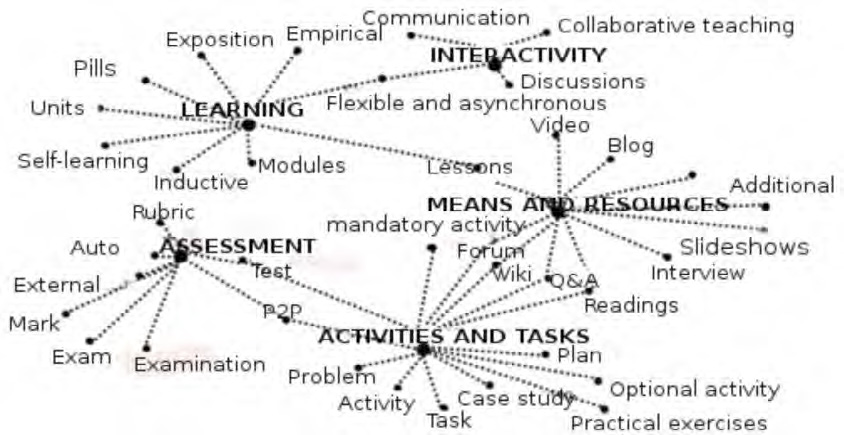

Figure 1 shows the relationship between categories and associated codes, taking into account that some codes belong to more than one category.

Figure 1: Existing relationship between categories and associated codes.

Two algorithms of data mining were applied, which will later be described in detail herein: first, a classification algorithm to discern the impact of platforms on the instructional and communication designs underlying the courses; second, an assessment algorithm to ascertain the degree of information provided by the variable course regardless of the platform provider.

3.1. What profile do Spanish-language MOOCs present?

The analysis conducted with the information compiled reveals that the 98.3% of the courses (n=115) have the title somewhere clearly visible, crucial in order to engage participants´ interest, as well as a limited registration period (n=38, 32.5%) or unlimited registration period (n=34, 29.1%). In 38.5% of the cases (n=45) registration was closed during the study timeframe.

A total of 72.6% (n=85) are sponsored by platforms linked to Higher Education; whilst personal initiative (n=13, 11.1%) or private company sponsors (n=1, 0.9%) are less frequent. As far as fields of knowledge are concerned, almost half of the MOOCs relate to Legal and Social fields (n=49, 41.9%), followed by multidisciplinary MOOCs (n=21, 17.9%), Arts and Humanities together with Science MOOCs (n=15 each, 12.8%). The least offered are Technology (n=10, 8.5%) and Health Sciences MOOCs (n=7, 6%).

Courses analyzed, only n=49 (41.9%) of the participants specify course relevance. More than half (n=63, 53.8%) lack addressee information. When addressing target participants, n=34 (29.1%) they note for public at large and n=20 (17.1%) establish a specific profile. In almost 60% of the courses (n=70, 59.8%) there are no prerequisites. Regarding the two last issues there are five important aspects that prompt registration:

• Including an Introduction to the course in the MOOC website. Almost half of the introductions deal with content (n=47, 40.2%), followed by 38.5% (n=45) which focus on the topic, without being too concise. The rest (n=25, 21.4%) address issues such as timing, objectives, using the system, carrying out tasks, etc.

• Having an introductory video, available in practically all of the courses analyzed (n=98, 83.8%).

• Having and defining objectives is omitted in more than half of the courses (n=67, 57.3%).

• MOOC related courses were only available in a small percentage of the courses (n=38, 32.5%)

• Operation of the system is specifically addressed in the platform in most MOOCs (n=91, 77.8%), only in 9.4% (n=11) is this guidance provided via course. In n=14 (12%) it is not specified.

The length of the MOOC analyzed is normally limited to weeks (n=87, 74.4%) ranging from 6 weeks (n=22, 36.7%) to 7-8 weeks (n=19, 31.7%). Thus, unlimited course length is a rare occurrence (n=11, 9.4%). Furthermore, the duration of engagement is specified in n=83 (70.9%), generally ranging from 3 hours (n=28, 46.7%) to more than 5 hours per week (n=19, 31.7%). Less than 2 hours of weekly engagement is infrequent (n=5, 8.3%).

A high percentage (n=84, 71.8%) of courses present the MOOC teaching team in a visible area, with an average of 3 to 4 tutors (M=3.32 and SD=3.148). This information is not displayed in only 17.1% (n= 20) and the remaining courses (n=11, 9.4%) provide no information at all.

Regarding course content there is a tendency to adopt an open structure, lessons or modules (n=90, 76.9%) with an average of 8 modules per MOOC. Less frequently (n=22, 18.8%), it appears that the work plan is limited to weeks only in closed structure courses. There is no information available in n=5 courses (4.3%)..

As for certification, there is a combination (n=75, 64.1%) of free of charge and charge-bearing modalities. Regarding the type of accreditation, it is normally mixed (n=71, 60.7%), certificates, credentials, badges, medals, and so on.

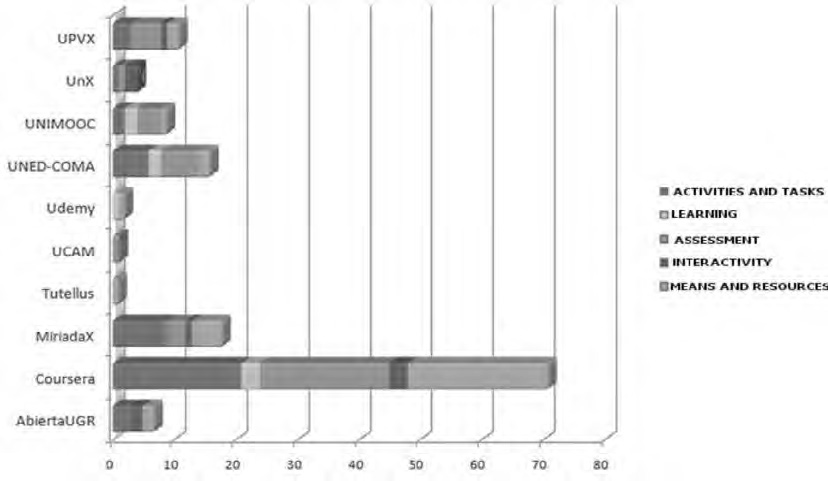

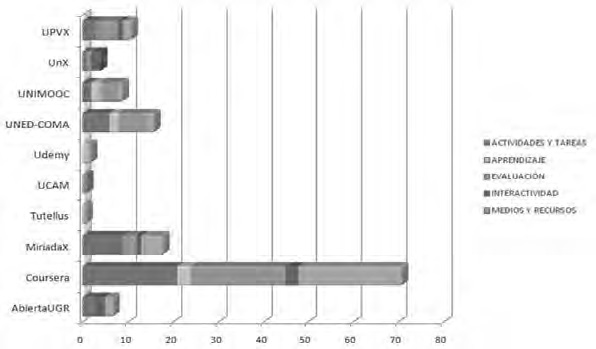

The content analysis resulting from the five categories (activities and tasks, learning, assessment, interactivity, means and resources) previously mentioned displays the given trend within each platform (figure 2).

Figure 2: Educational and interactive features related to the platform.

Regardless of the number of courses within each platform, it is noted that Coursera offers higher quality information with regard to educational and interactive features, followed by MiriadaX and UNED-COMA. On the other hand, and except in the aforementioned three platforms, it is observed that platforms are more vulnerable to and deficient in features such as means and resources, activities, tasks and assessment.

3.2. Do platforms condition pedagogical designs?

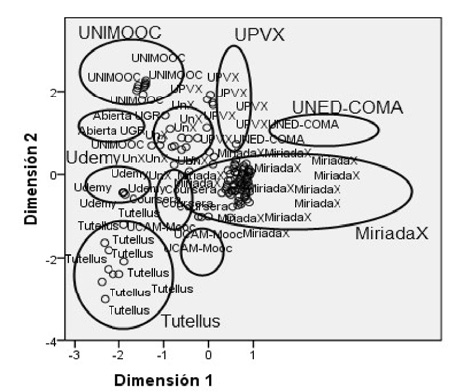

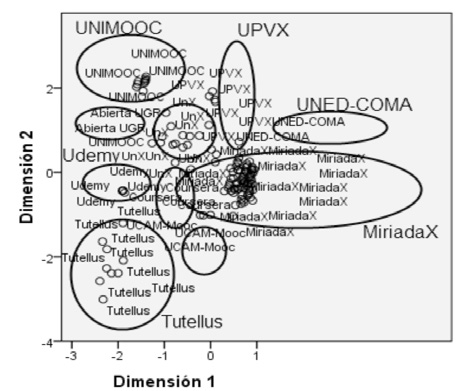

To address this issue a categorical principal component analysis (CATPCA) is carried out, which is non-linear and therefore does not require the strict assumptions of principal component analyses (Molina & Espinosa, 2010), regarding two dimensions as necessary and sufficient to yield representation (figure 3).The data obtained confirms that the amount of variance accounted for by these two dimensions is not high (s2=10.64%), but underscores a substantial difference among courses within different platforms. In the first dimension the saturating variables are: certification (.943), engagement (.905), dedication_hours (.899), accreditation (.864), registration (-.872) and institution (-.883). The variables that saturate the second dimension are: introductoryvideo (-.717), teaching team (80,625), faculty profiles (.608) and modules (-.629). Although there are variables that do not cluster significantly in any dimension, it is true that the vast majority have opposing values in one or another.

Figure 3: Object points/components labeled by means of platform.

Plotting the two dimensions in a coordinate axis displays how courses are grouped according to the platform provider. The outcome reveals the following facts:

• Some platforms are more extensive than others, for instance UniMOOC is within the values x=-2 and y=2, whilst MiriadaX extends from x=-1.

• There is certain affinity among platforms, which can lead to conglomerates, inter alia, Coursera and MiriadaX, UniMOCC and UPVX...

• In the sample studied the pedagogical components of each course are fully determined by the platform that hosts them.

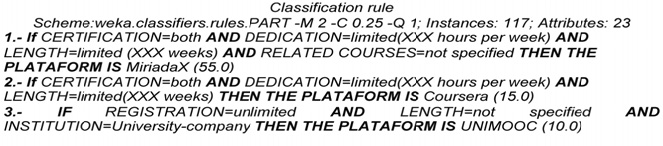

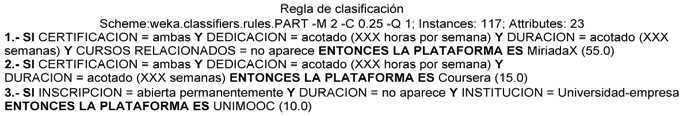

To give an in-depth insight, the data collected were subjected to an algorithm classification with Weka software (Hall & al., 2009).Since we are dealing with a collection of automatic learning algorithms for data mining tasks, the platforms under investigation are regarded as the classification variable and producing ten rules that classify 100% of the courses in a platform. The algorithm used was PART (Frank & Witten, 1998), a variant of the C4.5 of Quinlan (1993). As an example we provide a fragment of three rules:

The outcome demonstrates that the relevance of the platform is greater than that of each course when it comes to the pedagogical design. For instance, we observed that in MiriadaX, where more courses were analyzed, both types of certification, dedication and limited course length, together with not displaying related courses, are associated with this platform (n=55.0, i.e., all the courses examined).

3.3. Which MOOC components are platform-independent?

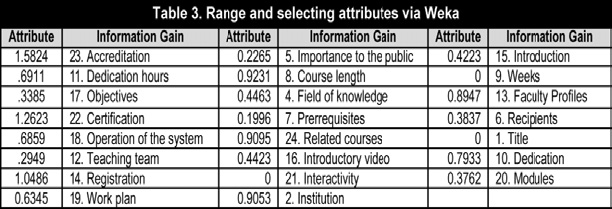

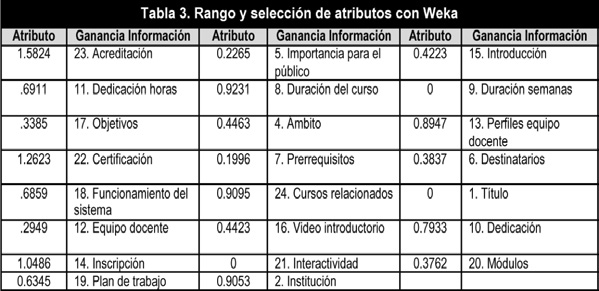

To examine what components are more specific to the course than to the platform, the data were subjected to an algorithm implemented in Weka which assesses the rate of each attribute by measuring the information gain3 (Witten, Frank & Hall, 2011) according to java class platform (table 3).

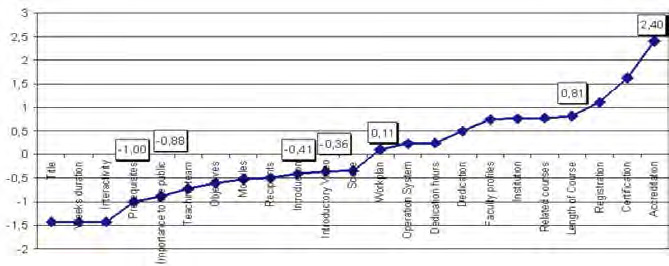

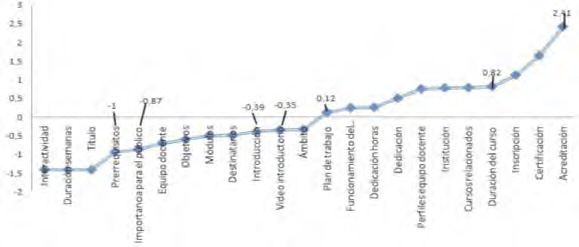

It is noted that most of the information provided by the variables is related to the platform. The title and interactivity variables do not display any variance; hence it can be attributed neither to course or platform. Figure 4 shows the values obtained through the algorithm once standardized. If negative values are to be taken as typical course variables, the following should be considered: Field, Introductory Video, Introduction, Target participants, Modules, Objectives, Teaching team, Importance to the public, Prerequisites and Lenght/weeks. If we increase to a DT=-1, the typical course variables would be Weeks and Prerequisites.

Figure 4: Relationship between course and platform.rma.

4. Discussion and conclusions

An overview of literature addressing MOOCs emphasizes the relevance of pedagogy in MOOCs. The use of the instrument (INdiMOOC-EdI), which enables an analysis of these components, was contemplated and implemented and has been applied to a total of 117 Spanish-language courses.

The study on the data obtained with the aforementioned instrument regarding descriptive, educational and interactive features determines that it can be employed as a benchmark of indicators in order to attain the desirable pedagogical design in a MOOC Some of the findings affirm, along with Glance & al. (2013), that MOOCs have a sound pedagogical basis and there is no reason to assume that they are less effective than other learning experiences.

Initially the variable course is analyzed; however, the data refer to the support platforms. The information obtained underscores a series of components that are not persistent in the vast majority of the courses analyzed. For instance, platforms do not regard it essential to specify: target participants, prerequisites and a clear and concise introduction about the course content or other related courses. Nonetheless, it does seem necessary to display: an introductory video; objectives, teaching team, length and weekly dedication, operation of the system, means and resources, activities and assessment. It has been shown that assessment is one of the most evident pedagogical benefits of MOOCs (Glance & al., 2013).

The existing profile of Spanish-language MOOCs, drawn from the pedagogical features in more than 70% of the courses examined, includes key features such as displaying the course title in a visible place (98.3%); an introductory video (83.8%); specifically addressing operation of the system (77.8%); an open structure, modules or lessons (76.9%) with an average of 8 modules per MOOC; course length limited to weeks (74.4%); platform provider linked to Higher Education (72.6%), displaying the teaching team in a visible spot (71.8%) and specifying the number of hours of weekly dedication (70.9%).

Although the platform offers the necessary technological support, it is obvious that MOOC proposals should have their own autonomy. Contrary to what is asserted in the study by Roig & al. (2014), which found no significant variance between the pedagogical quality of MOOC and the platform, it is ascertained that platforms determine the pedagogical design of the courses. The same pattern comprising, inter alia, activities and materials, learning modalities, assessment proposals, level of interactivity, access and certification is repeated over and over again (as many times as the number of platforms examined). The characteristics of the activities students carry out along with tutor counselling and didactic interventions are key elements in predicting the rate of disengaging and drop-outs (Halawa & al., 2014).

The data implies that platforms condition the pedagogical designs of MOOCs (figure 3), but this does not necessarily imply the existence of a pedagogical model underlying the MOOC proposal. I.e., the platform constrains and restricts online courses, albeit some platforms deploy a degree of flexibility, with fluid boundaries among the different features in INdiMOOC-EdI.

If MOOCs are regarded as a dynamic and global phenomenon, as an educational response to the emergence and development of movements and online social networks, as a cybernetic alternative to learning without frontiers, as a useful self-directed learning experience, as an extension of the classroom, as a space for free movement of knowledge, as an opportunity for democratization and universal access to specialized content, as a training proposal with pedagogic autonomy..., then let us take advantage of these mentoring platforms whilst MOOCs have not fully matured.

Finally, an exploratory study such as the one carried out provides an outline of the situation, but it is faced with certain constraints that should be addressed in future research, such as an in-depth insight into the field or methodological complementariness. It would be convenient to thoroughly examine a specific course or courses in specific fields of knowledge; the standpoint in other languages; or if low completion rates can be due to the pedagogical design. As stated by Bartolomé (2013), we still lack a pedagogical framework that will validate that a MOOCs teaches and that a MOOC generates knowledge. Further research is needed for ongoing progress and consolidation. There is as yet the need to debug concepts, models and experiences..., overcome certain difficulties and minimize others; some MOOCs and platforms will lag behind, but many others will continue to be designed, developed and improved for millions of people around the world.

Notes

1 The study was carried out during the last academic year in response to an institutional innovation project commissioned to the research group which includes the authors of this paper.

2 Despite the evident educational value objectives possess, they are included in the descriptive features in order to simply determine whether they are present or not, since according to Roig & al. (2014: 37): ‘The existence of explicit learning objectives is associated with a high score in the pedagogical quality of MOOCs’.

3 Information Gain=Class Entropy - Entropy (class / attribute)= Class H-H (Class /Attribute).

References

Aguaded, I. (2013). La revolución MOOCs, ¿una nueva educación desde el paradigma tecnológico? Comunicar, 41, 7-8. (DOI: http://doi.org/tnh).

Anderson, T. & McGreal, R. (2012). Disruptive Pedagogies and Technologies in Universities. Education, Technology and Society, 15, 4, 380-389. (http://goo.gl/H1mTkh) (25-11-2013).

Baggaley, J. (2014). MOOC Postscript. Distance Education, 35, 1, 126-132. (DOI: http://doi.org/tnj).

Bartolomé, A. (2013). Qué se puede esperar de los MOOC. Comunicación y Pedagogía, 269-270, 49-55.

Baxter, J.A. & Haycock, J. (2014). Roles and Student Identities in Online Large Course Forums: Implications for Practice. International Review of Research in Open and Distance Learning, 15, 1, 20-40. http://goo.gl/RxOzmt) (13-04-2014).

Conole, G. (2013). MOOCs as Disruptive Technologies: Strategies for Enhancing the Learner Experience and Quality of MOOCs. RED, 39, 1-18. (http://goo.gl/6Q8GLP) (24-03-2014).

Cormier, D. & Siemens, G. (2010). Throught the Open Door: Open Courses as Research, Learning & Engagement. Educase Review, 45, 4, 30-39. (http://goo.gl/AwTZhZ) (11-03-2014).

Cortina, J.M. (1993). What is Coefficient Alpha? An Examination of Theory and Applications. Journal of Applied Psychology, 78, 1, 98-104. (http://goo.gl/PL0fxu) (12-12-2013).

Creswell, J.W., Plano, V.L., Gutmann, M.L. & Hanson, W.E. (2008). Advanced Mixed Methods Research Designs. In V.L. Plano & J.W. Creswell (Eds.), The Mixed Methods Reader (pp. 161?196). Thousand Oaks, CA (USA): Sage.

Fini, A. (2009). The Technological Dimension of a Massive Open Online Course: The Case of the CCK08 Course Tools. The International Review of Research in Open and Distance Learning, 10, 5, 1-26. (http://goo.gl/YlU659) (08-09-2013).

Frank, E. & Witten, I.H. (1998). Generating Accurate Rule Sets without Global Optimization. Comunicación 15th International Conference on Machine Learning, Madison, Wisconsin. (http://goo.gl/FRQkET) (08-09-2013).

García, A. (2011). Técnicas actuales de estadística aplicada. Madrid: UNED.

Glance, D.G., Forsey, M. & Riley, M. (2013). The Pedagogical Foundations of Massive Open Online Courses. First Monday, 18, 5, 1-10. (DOI: http://doi.org/tkp).

Haggard, S. (2013). Massive Open Online Courses and Online Distance Learning: review. GOV.UK Research and Analysis. UK: Universities UK. (http://goo.gl/W3T6mO) (27-02-2014).

Halawa, S., Greene, D. & Mitchell, J. (2014). Dropout Prediction in MOOCs using Learner Activity Features. ELearning Papers, 37, 3-12. (http://goo.gl/l1vdWl) (19-03-2014).

Hall, M., Frank, E., Holmes, G., Pfahringer, B., Reutemann, P. & Witten, I. H. (2009). The WEKA Data Mining Software: An Update. SIGKDD Explorations, 11, 1, 10-18. (http://goo.gl/0k0a90) (23-11-2013).

Hernández, R., Fernández, C. & Baptista, P. (2010). Metodología de la investigación. Madrid: Pearson.

Huh, J., Delorme, D.E. & Reid, L.N. (2006). Perceived Third-Person Effects and Consumer Attitudes on Prevetting and Banning DTC Advertising. Journal of Consumer Affairs, 40, 1, 90-116. (DOI: http://doi.org/dpj596).

Jordan, K. (2014). Initial Trends in Enrolment and Completion of Massive Open Online Courses. The International Review of Research in Open and Distance Learning, 15, 1, 133-160. (http://goo.gl/PHWxaJ) (17-04-2014).

Koutropoulos, A., Gallagher, M.S., Abajian, S.C., deWaard, I., Hogue, R.J., Keskin, N.Ö. & Rodriguez, C.O. (2012). Emotive Vocabulary in MOOCs: Context & Participant Retention. European Journal of Open, Distance and E-Learning. 1, 1-23. (http://goo.gl/xO6dHU) (21-11-2013).

Lawshe, C.H. (1975). A Quantitative Approach to Content Validity. Personnel Psychology, 28, 563-575. (http://goo.gl/ql6Gyn) (26-06-2014).

Liyanagunawardena, T., Adams, A. & Williams, A. (2013). MOOCs: A Systematic Study of the Published Literature 2008-12. The International Review of Research in Open and Distance Learning, 14, 3, 202-227 (http://goo.gl/6vLnt8) (20-03-2014).

Martínez, F., Rodríguez, M.J. & García, F. (2014). Evaluación del impacto del término «MOOC» vs «Elearning» en la literatura científica y de divulgación. Revista de Currículum y Formación del Profesorado, 18, 1, 186-201. (http://goo.gl/HZPhKX) (25-06-2014).

McMillan, J. & Schumacher, S. (2005). Investigación educativa. Madrid: Pearson.

Medina, R. & Aguaded, I. (2014). Los MOOC en la plataforma educativa MiriadaX. Revista de Currículum y Formación del Profesorado, 18, 1, 137-153. (http://goo.gl/QCTZqL) (23-06-2014).

Molina, O. & Espinosa, E. (2010). Rotación en análisis de componentes principales categórico: un caso práctico. Metodología de encuestas, 12, 63-88.

Nunnally, J.C. (1967). Psychometric Theory. New York: McGraw-Hill.

Pernías, P. & Luján, S. (2013). Los MOOC: Orígenes, historia y tipos. Comunicación y Pedagogía, 269-270, 41-47.

Quinlan, J.R. (1993). C4.5: Programs for Machine Learning. San Mateo, CA: Morgan Kaufmann.

Rodríguez, C.O. (2012). MOOCs and the AI-Stanford Like Courses: Two Successful and Distinct Course Formats for Massive Open Online Courses. European Journal of Open, Distance and E-Learning, 2, 1-13. (http://goo.gl/JG2aix) (19-09-2013).

Roig, R., Mengual-Andrés, S. & Suárez, C. (2014). Evaluación de la calidad pedagógica de los MOOC. Profesorado. Revista de Currículum y Formación del Profesorado, 18, 1, 27-41. (http://goo.gl/hE7TSe) (23-06-2014).

Siemens, G. (2005). Connectivism: A Learning Theory for a Digital Age. International Journal of Instructional Technology and Distance Learning, 2, 1, 3-6. (http://goo.gl/MAzRa8) (11-09-2013).

Vázquez-Cano, E. (2013). El videoartículo: nuevo formato de divulgación en revistas científicas y su integración en MOOCs. Comunicar, 41, 83-91. (DOI: http://doi.org/tnk).

Vázquez-Cano, E., López, E. & Sarasola, J.L. (2013). La expansión del conocimiento en abierto: los MOOC. Barcelona: Octaedro.

Witten, H., Frank, E. & Hall, M. (2011). Data Mining. Practical Machine Learning Tools and Techniques. Elsevier: Burlington.

Yuan, L. & Powell, S. (2013). MOOCs and Open Education: Implications for Higher Education. UK: Cetis.

Zapata, M. (2013). MOOCs, una visión crítica y una alternativa complementaria: La individualización del aprendizaje y de la ayuda pedagógica. Campus Virtuales, 1 (II), 20-38. (http://goo.gl/2r98ZQ) (11-03-2014).

Click to see the English version (EN)

Resumen

A finales de la primera década del siglo XXI, el rápido aumento de cursos MOOC dibuja un nuevo panorama educativo planteando nuevos retos a la enseñanza y al aprendizaje debido, fundamentalmente, a sus características de masividad, ubicuidad y gratuidad. En estos cursos se da una confluencia de mediaciones tecnológicas y pedagógicas aún por explorar en todas sus dimensiones. Este trabajo, utilizando un instrumento de indicadores educativos e interactivos en un MOOC (INdiMOOC-EdI) de elaboración propia, se centra en averiguar qué componentes pedagógicos posee la actual oferta de MOOC en lengua hispana, para poder dirimir aquellos elementos dependientes de las plataformas que los soportan. Para ello se realiza una investigación mixta de tipo exploratoria y secuencial que analiza un total de 117 cursos ubicados en 10 plataformas diferentes, utilizando el instrumento creado y validado a tal efecto. Con la información obtenida se lleva a cabo un análisis de contenido en su vertiente cualitativa, mientras que con la cuantitativa se efectúan análisis estadísticos complementados con algoritmos propios de la minería de datos. Los resultados muestran que las diferentes plataformas condicionan los diseños pedagógicos del MOOC en cinco aspectos fundamentales: el aprendizaje, las actividades y tareas, los medios y recursos, la interactividad y la evaluación. Se concluye con una serie de indicadores de tipo descriptivo, formativo e interactivo que pueden orientar la pedagogía de futuros Cursos Online Masivos Abiertos.

1. Introducción y estado de la cuestión

Los MOOC son objeto de interés preferente en la comunidad científica con una literatura reciente y en aumento exponencial (Liyanagunawardena, Adams & Williams, 2013; Martínez, Rodríguez & García, 2014; Yuan & Powell, 2013). Por su filosofía estos cursos se extienden a nivel mundial siendo un claro ejemplo de disrupción (Anderson & McGreal, 2012; Conole, 2013; VázquezCano, López & Sarasola, 2013) debido a su coste, el número de estudiantes que admite y su adecuación a las nuevas necesidades sociales con respecto a la educación; aunque el carácter disruptivo de los MOOC solo se verifica si son tomados como experimentos para poner a prueba nuevas metodologías, nuevas tecnologías y nuevas formas de organizar la educación (Pernías & Luján, 2013).

Desde un enfoque pedagógico, más que una disrupción se trata de una efervescencia (Roig, MengualAndrés & Suárez, 2014), en la que no debe cegarnos la reacción que causan. Estos cursos se asientan en variadas y diversas plataformas, con orígenes y enfoques diferentes, dando lugar a MOOC, por ejemplo, basados en: el aprendizaje distribuido en red, fundamentado en la teoría conectivista y su modelo de aprendizaje (Siemens, 2005); las tareas, según las habilidades del alumnado en la resolución de determinados tipos de trabajo (Cormier & Siemens, 2010) y los contenidos (Pernías & Luján, 2013; VázquezCano, 2013).

Desde sus orígenes, la mayoría de los trabajos generados se han centrado fundamentalmente en la historia y concepto de MOOC; debatir los desafíos, amenazas y oportunidades del mismo; plantear estudios de caso examinando una o más plataformas y cursos; reflexionar sobre la participación de los estudiantes en MOOC (Liyanagunawardena & al., 2013). Tras ello, el foco de atención se traslada principalmente a las tasas de éxito y calidad del propio curso (Baxter & Haycock, 2014; Halawa, Greene & Mitchell, 2014; Jordan, 2014; Koutropoulos & al., 2012; Rodríguez, 2012), y a los fundamentos pedagógicos (Glance, Forsey & Riley, 2013; Roig & al., 2014; VázquezCano & al., 2013; Zapata, 2013), sin embargo, el diseño y componentes imprescindibles se abordan tangencialmente.

Aunque hay una falta de consenso sobre cómo debería llevarse a cabo la calidad de los MOOC (Haggard, 2013) es necesario plantearla para evitar que se conviertan en «un simple visionado de vídeos de poca calidad con profesores parlantes de un solo plano, sobre los que se construyen una serie de preguntas de autoevaluación y se generan expediciones de certificados sin tener constancia de la autentificación de la persona que lo ha realizado, sin más preocupaciones que el ingreso económico» (Aguaded, 2013: 78).

Para ello, es importante atender a qué información previa al curso se proporciona, los enfoques pedagógicos sobre los que se diseña, el nivel de compromiso de los estudiantes, el papel del equipo docente, la disponibilidad y el nivel de interacción, la tipología de recursos que contiene, la estructura y el proceso de certificación (VázquezCano, 2013; Zapata, 2013).

La investigación sobre estas propuestas formativas evidencia también que se asientan en el control descentralizado de los procesos de enseñanzaaprendizaje (Baggaley, 2014). Sin embargo, dado el carácter abierto y masivo de los MOOC existe una inmensa diversidad de usuarios con variedad de intereses y motivaciones, enfoques y estilos de aprendizaje; lo que hace que uno de los retos más difíciles sea proporcionar experiencias de aprendizaje auténtico, que exigen del diseño y desarrollo de procesos colaborativos e interactivos. Según afirma Siemens (2005), las actividades que se plantean de cooperación y colaboración así como la interacción con los recursos tecnológicos inciden de manera directa en el estudiante, en su modo de percibir y procesar la información y, por consiguiente, en sus procesos de aprendizaje, generándose así una nueva manera de construir el conocimiento. Considerando la masividad de estos cursos, el nivel de interactividad se plantea con el uso de herramientas colaborativas y comunicativas propias de la Web 2.0: chats y foros (Baxter & Haycock, 2014) para debatir dudas y compartir soluciones; blogs, wikis y redes sociales, entre otras, como soporte o resultado de actividades.

La evaluación suele responder a procesos finales y sumativos que vienen condicionados por las credenciales que acompañan la superación de un determinado MOOC. En unos casos, los objetivos se concretan en metas pequeñas que realizadas individualmente o por pares son evaluadas a través de encuestas, cuestionarios, test, exámenes, problemas y otros procesos, generando automáticamente insignias como evidencia de que se ha desarrollado una experiencia de aprendizaje.

En definitiva, la atención de los estudios se ha dirigido más hacia las características de las plataformas donde se alojan y el éxito o fracaso de un determinado curso (Fini, 2009) y menos a su perspectiva pedagógica. Si queremos maximizar el aprendizaje mediante el análisis y la adaptación de las estrategias de enseñanza a los individuos, debemos abordar de forma crítica el diseño pedagógico de los MOOC, para ver qué tendencia subyace. Con estos antecedentes, la investigación que se presenta plantea los siguientes objetivos:

• Analizar la oferta disponible en habla hispana durante un período determinado para poder establecer un perfil de componentes pedagógicos.

• Validar un instrumento que pueda orientar el diseño pedagógico de los MOOC.

• Dirimir elementos de un MOOC propios de aquellos dependientes de la plataforma.

• Determinar si los componentes pedagógicos de los MOOC están condicionados por las plataformas.

2. Material y métodos

Esta investigación1 posee una intencionalidad descriptiva con un diseño mixto de tipo exploratorio secuencial (DEXPLOS) (Creswell, Plano, Gutmann & Hanson, 2008; Hernández, Fernández & Baptista, 2010). Dicho diseño implica una fase inicial de recolección y análisis de datos cualitativos seguida de otra donde se recaban y analizan datos cuantitativos, posteriormente, se obtiene otra base de datos que integra ambas y que permite técnicas de análisis de mixtura (García, 2011).

Se utiliza un muestreo criterial (McMillan & Schumacher, 2005) y secuencial para métodos mixtos (Hernández & al., 2010). Los cursos se han seleccionado en base a los siguientes criterios: catalogados en el repositorio www.mooc.es; de idioma español; con la información disponible sin tener que matricularse en la plataforma; y proporcionan un nivel mínimo de información en el instrumento de recogida de datos.

Así, nos centramos en diez plataformas (Abierta UGR, Coursera, MiriadaX, Tutellus, Ucam, Udemy, UnedComa, UniMOOC, UnX, UPVX), descartando en primera instancia algunas como: Ehusfera (un servicio de alojamiento de blogs más que una plataforma de MOOC), Iversity, Coursesites y edX, entre otras, porque su idioma de referencia no es español. Esto supuso analizar 117 cursos de diferentes áreas de conocimiento accesibles durante el mes de marzo de 2014 (tabla 1). El bajo porcentaje perteneciente a las plataformas Tutellus y Udemy se debe, principalmente, a dos factores:

• La inclusión en ellas de cursos que no pueden encuadrarse dentro de la categoría MOOC, como son conferencias, videoconferencias o clases magistrales en soporte audiovisual, que sugieren ser un reciclaje de materiales de diferentes procedencias pertenecientes al repositorio audiovisual de una institución para ahora ser presentados como cursos masivos.

• La escasa información que aportan para el instrumento de investigación sin ser necesaria la inscripción en la plataforma. Por ejemplo, información redundante sobre el manejo de la plataforma, certificaciones, etc. Se observa una saturación semántica, tal que con independencia del curso, los datos proporcionados son los mismos.

Por tanto, estas dos plataformas no se tienen en cuenta para la determinación de la muestra cualitativa. Así se puede confirmar que los 104 cursos restantes significan el 81.25% de la población.

2.1. Instrumento

Para el análisis de los cursos masivos se elabora en este estudio INdiMOOCEdI (Instrumento de Indicadores Educativos e Interactivos en un MOOC). Se trata de una ficha ad hoc que recoge de forma exhaustiva la información ofertada como carta de presentación de los MOOC. Los elementos que configuran dicho instrumento se pueden organizar en cuatro componentes, con un total de 27 subcomponentes medidos en varias escalas (tabla 2).

Para asegurar las condiciones de validez, la primera versión del instrumento fue sometida a una técnica Delphi evaluando los mismos cursos en el mismo período de tiempo, y un estudio piloto con 15 cursos de 5 plataformas diferentes. El índice de competencia experta del panel (KC) fue de 0.75, siendo el índice de validez de contenido (IVC) de 0.99, lo que según Lawshe (1975) podría considerarse como suficiente. La fiabilidad y consistencia interna se averiguó mediante el estadístico alfa de Cronbach tras la recolección de la muestra; una vez eliminadas del análisis las cuestiones cuyas respuestas estaban medidas en escala de intervalo. El valor alfa obtenido para los 117 cursos ha sido de 0.614. Algunos autores (Huh, Delorme & Reid, 2006; Nunnally, 1967) indican que un valor alfa entre 0.5 y 0.6 puede ser suficiente en las primeras fases de investigaciones o en las de corte exploratorio, como la presente. Dicho estudio estadístico combina el índice de correlación entre los elementos que componen el instrumento y la dimensionalidad del mismo (Cortina, 1993).

3. Análisis y resultados

Se efectúa un análisis descriptivo de los datos cuantitativos según los elementos de identificación y aspectos descriptivos indicados en la tabla 2, junto con un análisis de componentes principales categóricos que permite agrupar un conjunto elevado de variables en un número menor de componentes explicativos que parte de la varianza existente entre los datos originales.

Con los datos cualitativos (aspectos formativos e interactivos) se realiza un análisis de contenido que ha derivado en el establecimiento de cinco grandes categorías:

• Aprendizaje: tipo, modalidad de aprendizaje que se desarrolla y formato de contenidos a aprender: autoaprendizaje, aprendizaje empírico e inductivo, aprendizaje por observación; lecciones, unidades, píldoras o módulos.

• Actividades y tareas: modalidad (obligatorias u optativas, individuales o colectivas) y tipología (cuestionarios, test, lecturas, ejercicios prácticos, problemas, proyectos, casos de estudio, preguntas y respuestas, participación…).

• Medios y recursos: de carácter tecnológico y tradicional: vídeos, presentaciones, foros, blog, wiki, correo electrónico, entrevistas, lecturas, material adicional opcional.

• Interactividad: o interacción entre personas, engloba encuentros virtuales, debates o discusiones en pares o grupos, intercambios de dudas y conocimientos, trabajo colaborativo, comunicación flexible y asíncrona.

• Evaluación: propuesta de evaluación existente, tanto modalidades e instrumentos como cualificación y verificación (autoevaluación, evaluación de pares; cuestionarios, test, rúbricas, exámenes, problemas, actividades P2P –peer to peer–); porcentaje o ponderación en la nota final, escala de calificación, nota de superación, porcentajes mínimos; comprobación de la progresión del alumno/a y confirmación final.

En la figura 1 se muestra la relación existente entre las categorías y los códigos asociados, teniendo en cuenta que hay códigos que pertenecen a más de una categoría.

Figura 1: Relación existente entre categorías y códigos asociados.

Se aplicaron también dos algoritmos propios de la minería de datos, que se detallan más adelante: uno, de clasificación para poder ver el impacto de las plataformas sobre los diseños instructivos y comunicativos subyacentes a los cursos; otro, de evaluación para conocer el grado de información que aporta la variable curso con independencia de la plataforma en la que se ubica.

3.1. ¿Qué perfil de MOOC hay en habla hispana?

El análisis realizado con la información recabada revela que el 98,3% de los cursos (n=115) tiene el título en un lugar bien visible, importante para que despierte un primer interés en los destinatarios, al igual que la inscripción está abierta durante un tiempo determinado (n=38, 32,5%) o permanentemente (n= 34, 29,1%). En el 38,5% de los casos (n=45) no es posible inscribirse durante el período estudiado.

Un 72,6% (n=85) son MOOC promovidos desde plataformas con vinculación a la educación superior; los de iniciativa particular (n=13, 11,1%) o de empresa privada (n=1, 0.9%) son los menos frecuentes. Sobre el ámbito al que pertenecen, casi la mitad son del JurídicoSocial (n=49, 41,9%), seguido del multidisciplinar (n=21, 17,9%), Artes y Humanidades junto con el Científico (n=15 cada uno, 12,8%). Los menos ofertados son del ámbito Tecnológico (n=10, 8,5%) y Ciencias de la Salud (n=7, 6%).

La importancia para el público es explicitada solo en n=49 (41,9%). En más de la mitad (n=63, 53,8%) tampoco se indica a quién va dirigido. Cuando se refieren a los destinatarios, en n=34 (29,1%) señalan que es para público en general y en n=20 (17,1%) presentan un perfil concreto. En casi el 60% de los cursos (n=70, 59,8%) no se llega a establecer ninguna relación de prerrequisitos necesarios para su realización. Vinculado a estas dos últimas cuestiones existen cinco aspectos importantes que determinan la matrícula:

• El tipo de introducción que se hace desde la web de presentación del MOOC. En casi la mitad dicha introducción versa sobre el contenido (n=47, 40,2%), seguido de un 38,5% (n=45) que se centra en la propia temática, sin llegar a ser tan conciso. En el resto (n=25, 21,4%) se tratan cuestiones diversas como temporalización, objetivos, funcionamiento del sistema, resolución de tareas, etc.

• La presencia de un vídeo introductorio se da en casi la totalidad de los cursos analizados (n=98, 83,8%).

• La existencia y definición de los objetivos es omitida en más de la mitad de los cursos (n=67, 57,3%).

• La relación del MOOC con otros cursos se ha constatado en un porcentaje reducido (38, 32,5%).

• El funcionamiento del sistema es abordado en la mayoría de MOOC (n=91, 77,8%) explícitamente y orientado desde la plataforma, solo en un 9,4% (n= 11) se hace desde el curso;?en n=14 (12%) no se explicita.

Sobre la duración de los MOOC analizados, se constata una tendencia a estar acotados por semanas (n=87, 74.4%) con un promedio que oscila entre las seis (n=22, 36,7%) y las siete u ocho semanas (n=19, 31,7%). Así, tener una duración total indefinida es poco habitual (n=11, 9,4%). Además, se indican las horas necesarias de dedicación semanal en n=83 (70,9%), siendo frecuente las tres horas semanales (n=28, 46,7%) y más de cinco horas (n=19, 31,7%). Lo menos usual es un nivel de implicación de dos horas (n=5, 8,3%).

Un alto porcentaje (n=84, 71,8%) muestra preocupación por ofrecer en un lugar visible la composición del equipo que configura el MOOC, siendo la media de tres o cuatro docentes (M=3,32 y DT= 3,148). Solo en un 17,1% (n=20) esta información no está visible y en el resto (n=11, 9,4%) no se ofrecen datos.

En relación con los contenidos se identifica una tendencia a adoptar una estructura abierta, en módulos o lecciones (n=90, 76,9%) con una media de ocho módulos por MOOC. Con menor frecuencia (n=22, 18,8%), se observa que el plan de trabajo viene delimitado solo por semanas desde una estructura cerrada;?en n=5 cursos (4,3%) no se especifica nada.

En cuanto a la certificación, lo más frecuente (n=75, 64,1%) es una combinación de modalidades gratuita y de pago. Sobre el tipo de acreditaciones, resulta habitual que sea mixta (n=71, 60,7%), con certificados, credenciales, insignias, medallas...

Por otro lado, el análisis de contenido derivado de las cinco grandes categorías (actividades y tareas, aprendizaje, evaluación, interactividad, medios y recursos) descritas anteriormente, muestra cuál es la tendencia sobre ellas en las diferentes plataformas (figura 2).

Figura 2. Aspectos formativos e interactivos asociados a las plataformas.

Independientemente del número de cursos en cada plataforma, se observa que Coursera es la que ofrece mayor calidad en la información referida a los aspectos formativos e interactivos, seguida a bastante distancia por MiriadaX y UNEDCOMA. Por otro lado, y excepto en las tres citadas, se aprecia que son los medios y recursos, las actividades y tareas junto con la evaluación los aspectos en los que las plataformas son más sensibles o están más deficitarias.

3.2. ¿Las plataformas condicionan los diseños pedagógicos?

Para responder a esto se realiza un análisis de componentes principales categóricos a través de CATPCA, que al ser no lineal no requiere los estrictos supuestos del análisis de componentes principales (Molina & Espinosa, 2010), determinando dos como necesarios y suficientes para poder visualizar su representación (figura 3).

Figura 3. Puntos de objeto/componentes etiquetados mediante plataforma.

A través de los datos obtenidos se constata que la varianza explicada por estos dos componentes no es mucha (s2=10,64%), pero pone de manifiesto la gran diferencia entre los cursos pertenecientes a una u otra plataforma. En la primera componente saturan las variables certificación (.943), dedicación (.905), dedicación de horas (.899), institución (.883), inscripción (.872) y acreditación (.864). Las variables que saturan en la segunda componente son: vídeo introductorio (.717), equipo docente (80.625), perfiles del equipo docente (.608) y módulos (.629). Aun cuando existen variables que no saturan significativamente en ninguna componente, sí es cierto que la gran mayoría presentan valores contrapuestos en una u otra. Se observa en la proyección de los dos componentes en un eje de coordenadas, cómo los cursos se agrupan en función de la plataforma en la que se ubican. Este resultado pone de manifiesto los siguientes hechos:

• Hay plataformas más expansivas que otras, por ejemplo UniMOOC se concentra en torno a los valores x=2 e y=2, mientras que MiriadaX se dilata desde x=1.

• Hay cierta afinidad entre las plataformas, lo que puede derivar en conglomerados, entre otros, Coursera y MiriadaX, UniMOCC, UPVX…

• En la muestra estudiada los componentes pedagógicos de cada curso están plenamente determinados por la plataforma que los alojan.

Para argumentarlo más, se han sometido los datos recogidos a un algoritmo de clasificación con el programa Weka (Hall & al., 2009). Teniendo en cuenta que estamos ante una colección de algoritmos de aprendizaje automático para tareas de minería de datos, se toma como variable clasificatoria las plataformas estudiadas, obteniendo como resultado un conjunto de diez reglas que clasifican al 100% de los cursos en su plataforma. El algoritmo utilizado ha sido PART (Frank & Witten, 1998), una variante del C4.5 de Quinlan (1993). A modo de ejemplo se muestra un fragmento de tres reglas del algoritmo:

El resultado demuestra que la importancia de la plataforma en cuanto al diseño pedagógico es mayor que la que pueda tener cada curso. Por ejemplo, siendo la plataforma MiriadaX la que posee más cursos analizados, observamos que ambos tipos de certificación, dedicación y duración acotadas por semanas, junto con no indicar otros cursos relacionados, está asociado a dicha plataforma (n=55.0, esto es, la totalidad de los cursos estudiados en ella).

3.3. ¿Qué componentes del MOOC considerados son independientes de las plataformas?

Para examinar qué componentes son más propios del curso que de la plataforma, se han sometido los datos a un algoritmo implementado en Weka que evalúa el valor de cada atributo mediante la medición de la ganancia de información3 (Witten, Frank & Hall, 2011) con respecto a la clase plataforma (tabla 3).

Se constata que la mayor parte de la información aportada por las variables está relacionada con la plataforma. Las variables título e interactividad no presentan varianza alguna, de ahí que no se pueda atribuir ni a curso ni a plataforma. En la figura 4 se muestran los valores obtenidos mediante el algoritmo una vez normalizados. Si tomáramos como variables propias de curso las que tienen valores negativos habría que tener en cuenta las siguientes: ámbito, vídeo introductorio, Introducción, destinatarios, módulos, objetivos, equipo docente, Importancia para el público, prerrequisitos y duración semanas. Si aumentamos a una DT=1, las variables propias serían semanas y prerrequisitos.

Figura 4. Relación entre curso y plataforma.

4. Discusión y conclusiones

El recorrido por la literatura efectuado enfatiza cuestiones que muestran la relevancia de la pedagogía en los MOOC. Se ha planteado e implementado un instrumento (INdiMOOCEdI) que permite analizar dichos componentes y se ha aplicado sobre un total de 117 cursos de habla hispana.

El estudio sobre los datos obtenidos con dicho instrumento en torno a aspectos descriptivos, formativos e interactivos, determina que puede ser utilizado como un elenco de indicadores para el diseño pedagógico deseable en un MOOC. Algunos de ellos permiten afirmar junto con Glance y otros (2013) que los MOOC tienen una base pedagógica sólida y no hay razón para pensar que sean menos eficaces que otras experiencias de aprendizaje.

Se comienza estudiando la variable curso, sin embargo, los datos derivan a las plataformas de soporte. La información conseguida destaca una serie de elementos que no son habituales en la inmensa mayoría de cursos analizados. Por ejemplo, desde las plataformas no se percibe como fundamental explicitar: a quien se dirige, los prerrequisitos necesarios, una introducción clara y concisa sobre el contenido, otros cursos relacionados. Aunque sí parece necesario mostrar: un vídeo introductorio, los objetivos, el equipo docente, la duración y dedicación semanal, el funcionamiento del sistema, los medios y recursos, las actividades y la evaluación. Siendo ésta uno de los beneficios pedagógicos más evidente de los MOOC (Glance & al., 2013).

El perfil de MOOC existente en habla hispana, dibujado a partir de los elementos pedagógicos existentes en más del 70% de los cursos analizados, se caracteriza por tener el título en un lugar visible (98,3%), la presencia de un vídeo introductorio (83,8%), aborda explícitamente cómo funciona el sistema (77,8%), una estructura abierta, en módulos o lecciones (76,9%) con una media de ocho módulos por MOOC, su duración está acotada por semanas (74,4%), es propuesto desde plataformas con vinculación a la educación superior (72,6%), muestra la composición del equipo que configura el MOOC en un lugar visible (71,8%) e indica las horas necesarias de dedicación semanal (70,9%).

Aunque la plataforma ofrece un soporte tecnológico necesario, se ha visto que la propuesta de MOOC debería tener su propia autonomía. Al contrario de lo mostrado en el estudio de Roig y otros (2014), que no encuentran una diferencia significativa entre la calidad pedagógica de los MOOC y la plataforma que los contiene, hemos comprobado que el diseño pedagógico de los cursos analizados está determinado por ella. Se repite una y otra vez (tantas como plataformas estudiadas) el mismo patrón que conforman, entre otros, las actividades y materiales, modalidades de aprendizaje, propuestas de evaluación, nivel de interactividad, acceso y certificación. Las características de las actividades que realizan los estudiantes junto con las orientaciones docentes y sus intervenciones educativas, llegan a ser utilizadas como elemento fundamental en el modelo de predicción de abandono y deserción en los MOOC de Halawa y colaboradores (2014).

Los datos apuntan a que las plataformas condicionan los diseños pedagógicos de los MOOC (figura 3), pero esto no significa que necesariamente tengan un modelo pedagógico que subyace a su propuesta. Es decir, la plataforma constriñe y encorseta a los cursos online, si bien, en algunas de ellas hay cierta flexibilidad, con fronteras más «líquidas» entre los diferentes elementos de INdiMOOCEdI.

Si entendemos los MOOC como un fenómeno dinámico y global, como una respuesta en educación a la emergencia y desarrollo de movimientos y redes sociales, como alternativa cibernética a una educación sin fronteras, como una experiencia útil de autoaprendizaje, como una expansión de las aulas, como un espacio de libre circulación de conocimiento, como una oportunidad para la democratización y acceso universal a contenidos especializados, como una propuesta formativa con autonomía pedagógica..., aprovechemos, en este momento, el tutelaje de las plataformas mientras los propios MOOC no obtienen la mayoría de edad.

Para terminar, un estudio exploratorio como el realizado permite esbozar un mapa de la situación pero presenta algunas limitaciones que deberían ser abordadas en trabajos posteriores, como es la profundidad en el campo o la complementariedad metodológica. Sería oportuno analizar con mayor detalle el caso de algún curso o cursos en determinadas áreas de conocimiento; la situación en otros idiomas; o si el diseño pedagógico puede ser causa del alto índice de participantes que no los completan. Como afirma Bartolomé (2013), aún falta un marco de referencia pedagógico que permita asegurar que el MOOC enseña y que con el MOOC se aprende. Se precisan más investigaciones que indaguen en este movimiento para que siga avanzando y consolidándose. Habrá aún que depurar conceptos, modelos, experiencias…, superar dificultades encontradas y minimizar otras; algunos MOOC y plataformas se quedarán por el camino pero otros muchos se seguirán diseñando, desarrollando y mejorando para millones de personas en el mundo.

Notas

1 El estudio se realiza desde 2012/13 para dar respuesta a un proyecto de innovación institucional encargado al grupo de investigación del que forman parte los autores.

2 A pesar del valor formativo que evidentemente poseen los objetivos, son considerados en los elementos descriptivos porque simplemente se trata de constatar si están presentes o no, ya que según Roig y otros (2014: 37): «la existencia de unos objetivos de aprendizaje explícitamente planteados tiene relación con una alta puntuación en la calidad pedagógica de los MOOC».

3 Ganancia de Información=Entropía de la clase – Entropía (clase/atributo)=H Clase – H (Clase/Atributo).

Referencias

Aguaded, I. (2013). La revolución MOOCs, ¿una nueva educación desde el paradigma tecnológico? Comunicar, 41, 7-8. (DOI: http://doi.org/tnh).

Anderson, T. & McGreal, R. (2012). Disruptive Pedagogies and Technologies in Universities. Education, Technology and Society, 15, 4, 380-389. (http://goo.gl/H1mTkh) (25-11-2013).

Baggaley, J. (2014). MOOC Postscript. Distance Education, 35, 1, 126-132. (DOI: http://doi.org/tnj).

Bartolomé, A. (2013). Qué se puede esperar de los MOOC. Comunicación y Pedagogía, 269-270, 49-55.

Baxter, J.A. & Haycock, J. (2014). Roles and Student Identities in Online Large Course Forums: Implications for Practice. International Review of Research in Open and Distance Learning, 15, 1, 20-40. http://goo.gl/RxOzmt) (13-04-2014).

Conole, G. (2013). MOOCs as Disruptive Technologies: Strategies for Enhancing the Learner Experience and Quality of MOOCs. RED, 39, 1-18. (http://goo.gl/6Q8GLP) (24-03-2014).

Cormier, D. & Siemens, G. (2010). Throught the Open Door: Open Courses as Research, Learning & Engagement. Educase Review, 45, 4, 30-39. (http://goo.gl/AwTZhZ) (11-03-2014).

Cortina, J.M. (1993). What is Coefficient Alpha? An Examination of Theory and Applications. Journal of Applied Psychology, 78, 1, 98-104. (http://goo.gl/PL0fxu) (12-12-2013).

Creswell, J.W., Plano, V.L., Gutmann, M.L. & Hanson, W.E. (2008). Advanced Mixed Methods Research Designs. In V.L. Plano & J.W. Creswell (Eds.), The Mixed Methods Reader (pp. 161?196). Thousand Oaks, CA (USA): Sage.

Fini, A. (2009). The Technological Dimension of a Massive Open Online Course: The Case of the CCK08 Course Tools. The International Review of Research in Open and Distance Learning, 10, 5, 1-26. (http://goo.gl/YlU659) (08-09-2013).

Frank, E. & Witten, I.H. (1998). Generating Accurate Rule Sets without Global Optimization. Comunicación 15th International Conference on Machine Learning, Madison, Wisconsin. (http://goo.gl/FRQkET) (08-09-2013).

García, A. (2011). Técnicas actuales de estadística aplicada. Madrid: UNED.

Glance, D.G., Forsey, M. & Riley, M. (2013). The Pedagogical Foundations of Massive Open Online Courses. First Monday, 18, 5, 1-10. (DOI: http://doi.org/tkp).

Haggard, S. (2013). Massive Open Online Courses and Online Distance Learning: review. GOV.UK Research and Analysis. UK: Universities UK. (http://goo.gl/W3T6mO) (27-02-2014).

Halawa, S., Greene, D. & Mitchell, J. (2014). Dropout Prediction in MOOCs using Learner Activity Features. ELearning Papers, 37, 3-12. (http://goo.gl/l1vdWl) (19-03-2014).

Hall, M., Frank, E., Holmes, G., Pfahringer, B., Reutemann, P. & Witten, I. H. (2009). The WEKA Data Mining Software: An Update. SIGKDD Explorations, 11, 1, 10-18. (http://goo.gl/0k0a90) (23-11-2013).

Hernández, R., Fernández, C. & Baptista, P. (2010). Metodología de la investigación. Madrid: Pearson.

Huh, J., Delorme, D.E. & Reid, L.N. (2006). Perceived Third-Person Effects and Consumer Attitudes on Prevetting and Banning DTC Advertising. Journal of Consumer Affairs, 40, 1, 90-116. (DOI: http://doi.org/dpj596).

Jordan, K. (2014). Initial Trends in Enrolment and Completion of Massive Open Online Courses. The International Review of Research in Open and Distance Learning, 15, 1, 133-160. (http://goo.gl/PHWxaJ) (17-04-2014).

Koutropoulos, A., Gallagher, M.S., Abajian, S.C., deWaard, I., Hogue, R.J., Keskin, N.Ö. & Rodriguez, C.O. (2012). Emotive Vocabulary in MOOCs: Context & Participant Retention. European Journal of Open, Distance and E-Learning. 1, 1-23. (http://goo.gl/xO6dHU) (21-11-2013).

Lawshe, C.H. (1975). A Quantitative Approach to Content Validity. Personnel Psychology, 28, 563-575. (http://goo.gl/ql6Gyn) (26-06-2014).

Liyanagunawardena, T., Adams, A. & Williams, A. (2013). MOOCs: A Systematic Study of the Published Literature 2008-12. The International Review of Research in Open and Distance Learning, 14, 3, 202-227 (http://goo.gl/6vLnt8) (20-03-2014).

Martínez, F., Rodríguez, M.J. & García, F. (2014). Evaluación del impacto del término «MOOC» vs «Elearning» en la literatura científica y de divulgación. Revista de Currículum y Formación del Profesorado, 18, 1, 186-201. (http://goo.gl/HZPhKX) (25-06-2014).

McMillan, J. & Schumacher, S. (2005). Investigación educativa. Madrid: Pearson.

Medina, R. & Aguaded, I. (2014). Los MOOC en la plataforma educativa MiriadaX. Revista de Currículum y Formación del Profesorado, 18, 1, 137-153. (http://goo.gl/QCTZqL) (23-06-2014).

Molina, O. & Espinosa, E. (2010). Rotación en análisis de componentes principales categórico: un caso práctico. Metodología de encuestas, 12, 63-88.

Nunnally, J.C. (1967). Psychometric Theory. New York: McGraw-Hill.

Pernías, P. & Luján, S. (2013). Los MOOC: Orígenes, historia y tipos. Comunicación y Pedagogía, 269-270, 41-47.

Quinlan, J.R. (1993). C4.5: Programs for Machine Learning. San Mateo, CA: Morgan Kaufmann.

Rodríguez, C.O. (2012). MOOCs and the AI-Stanford Like Courses: Two Successful and Distinct Course Formats for Massive Open Online Courses. European Journal of Open, Distance and E-Learning, 2, 1-13. (http://goo.gl/JG2aix) (19-09-2013).

Roig, R., Mengual-Andrés, S. & Suárez, C. (2014). Evaluación de la calidad pedagógica de los MOOC. Profesorado. Revista de Currículum y Formación del Profesorado, 18, 1, 27-41. (http://goo.gl/hE7TSe) (23-06-2014).

Siemens, G. (2005). Connectivism: A Learning Theory for a Digital Age. International Journal of Instructional Technology and Distance Learning, 2, 1, 3-6. (http://goo.gl/MAzRa8) (11-09-2013).

Vázquez-Cano, E. (2013). El videoartículo: nuevo formato de divulgación en revistas científicas y su integración en MOOCs. Comunicar, 41, 83-91. (DOI: http://doi.org/tnk).

Vázquez-Cano, E., López, E. & Sarasola, J.L. (2013). La expansión del conocimiento en abierto: los MOOC. Barcelona: Octaedro.

Witten, H., Frank, E. & Hall, M. (2011). Data Mining. Practical Machine Learning Tools and Techniques. Elsevier: Burlington.

Yuan, L. & Powell, S. (2013). MOOCs and Open Education: Implications for Higher Education. UK: Cetis.

Zapata, M. (2013). MOOCs, una visión crítica y una alternativa complementaria: La individualización del aprendizaje y de la ayuda pedagógica. Campus Virtuales, 1 (II), 20-38. (http://goo.gl/2r98ZQ) (11-03-2014).

Document information

Published on 31/12/14

Accepted on 31/12/14

Submitted on 31/12/14

Volume 23, Issue 1, 2015

DOI: 10.3916/C44-2015-03

Licence: CC BY-NC-SA license

Share this document

Keywords

claim authorship

Are you one of the authors of this document?