1. Introducción

Este proyecto nace de la colaboración entre Airbus, FIDAMC y MTorres, con el propósito de desarrollar la consolidación in situ para termoplásticos. La consolidación in situ es un procedimiento desafiante, ya que requiere una gestión precisa de variables como temperatura, presión y tiempo para garantizar la calidad del producto final. En FIDAMC se ha desarrollado una aplicación de software para abordar el control de temperatura y recopilación de datos en tiempo real.

Las variables del proceso presentan una interdependencia y no linealidad considerable, lo que aumenta la complejidad del control. Se ha recurrido a herramientas de código abierto de análisis de datos y aprendizaje automático [1] para entrenar modelos que buscan mejorar la precisión y eficacia del control del proceso, permitiendo ajustes en tiempo real según las condiciones instantáneas del sistema físico.

En resumen, este proyecto es un esfuerzo conjunto para avanzar en el campo de la consolidación in situ de termoplásticos, mediante la adopción de tecnologías avanzadas y técnicas de aprendizaje automático. Los resultados obtenidos hasta la fecha son prometedores y sugieren posibilidades de mejoras significativas en la calidad y eficiencia del proceso de ISC.

2. Equipos y sistemas

El equipamiento utilizado en este proyecto ha sido seleccionado y configurado para proporcionar el control preciso y la flexibilidad requerida a la hora de estudiar y desarrollar el proceso de ISC para la fabricación de piezas de geometría compleja a altas velocidades.

Se emplea un robot de alta capacidad de carga para el movimiento y posicionamiento precisos del cabezal de encintado, que integra todos los componentes para la gestión y deposición de material, el calentamiento y prensado. Este cabezal se desplaza sobre la pieza de trabajo, depositando y compactando el material en capas sucesivas para formar la pieza final.

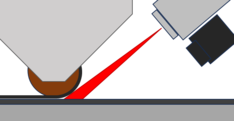

El sistema de calefacción es un láser de diodo segmentado capaz de calentar el termoplástico a las temperaturas necesarias para su fusión y consolidación. Su configuración segmentada permite un control detallado sobre el perfil de calor aplicado.

Una cámara termográfica se utiliza para monitorizar en tiempo real la temperatura del material durante el proceso de consolidación. Se han llevado a cabo procedimientos de calibración para garantizar la precisión de las mediciones de temperatura, ya que, por ejemplo, la emisividad del material puede variar con el ángulo de captura.

Figura 1. Esquema de proceso de calentamiento y prensado durante encintado

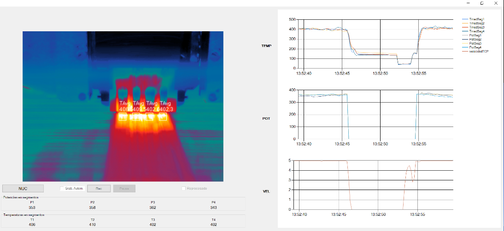

Se ha desarrollado una aplicación de software específicamente para fines de evaluación y optimización del proceso. Ésta se comunica con el sistema de encintado y la cámara termográfica, lo que permite controlar el calentamiento y capturar las variables del proceso en tiempo real, calcular una potencia para cada segmento láser y transmitir la señal al cabezal de laminación. La interfaz de usuario facilita la gestión de potencia y la monitorización del proceso. Además, genera un archivo de historial para análisis y trazabilidad posteriores.

Figura 2. Interfaz de software de control y monitorización

Con este sistema ha sido posible hacer ensayos a velocidades de encintado de hasta 30 m/min, lo que proporciona un rango amplio para experimentar y optimizar los parámetros del proceso.

3. Recopilación y análisis de datos

El sistema de control estudiado se basa en técnicas de control basadas datos, que tienen ventajas significativas sobre los enfoques de control convencionales. A diferencia de los métodos convencionales que a menudo se basan en modelos matemáticos simplificados del proceso, las técnicas basadas en datos pueden capturar y aprovechar la dinámica y las interacciones complejas que son inherentes al proceso de consolidación in situ.

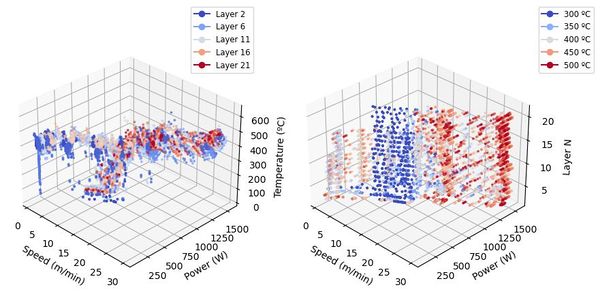

Las variables seleccionadas incluyen la temperatura de consigna y la medida, la potencia de cada segmento del láser, el número de capas y la velocidad de encintado. Su recopilación en tiempo real es necesaria para el análisis posterior y la construcción de modelos predictivos.

Dada la gran cantidad de datos recogidos (Figura 3), es necesario aplicar técnicas de filtrado para reducir el ruido y resaltar las tendencias subyacentes.

Figura 3. Representación de datos sin filtrar en múltiples variables

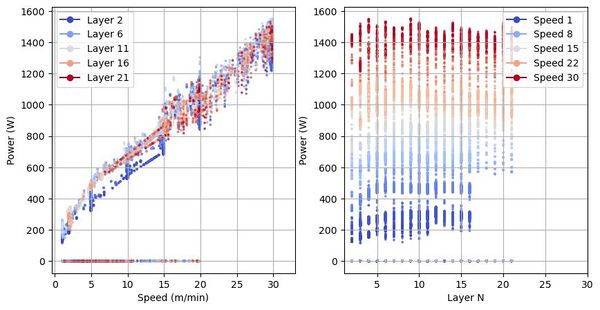

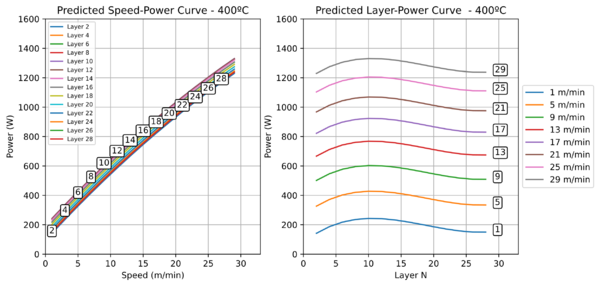

Figura 4. Gráficos Velocidad-Potencia y Capa-Potencia. Datos sin filtrar.

El análisis de estos datos revela correlaciones entre las variables. Por ejemplo, la velocidad y la potencia del láser están estrechamente relacionadas para una temperatura de consigna dada, pero esta relación es distinta entre la potencia y el número de capa que se encinta. Estas relaciones son útiles para entender y modelar el proceso de consolidación (Figura 4).

Finalmente, el objetivo del análisis de datos es construir un modelo predictivo que pueda calcular la potencia de salida requerida para una temperatura de consigna dada y lecturas instantáneas del resto de variables seleccionadas.

4. Generación de modelos

El objetivo es desarrollar un modelo de predicción que pueda estimar la potencia de salida necesaria para alcanzar una temperatura de consigna. Para ello, se han explorado dos enfoques principales [2] [3]: la regresión polinómica múltiple (MPR) y las máquinas de vectores de soporte (SVM).

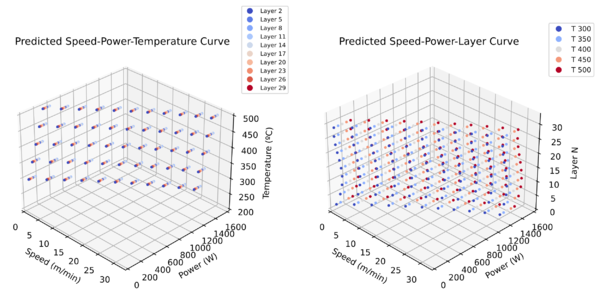

La regresión polinómica múltiple es una técnica de modelado que permite capturar relaciones no lineales entre las variables de entrada y de salida (1). En nuestro caso, las variables de entrada incluyen la temperatura de consigna (TempC), la velocidad de encintado (Vel) y el número de capas (NCapa), mientras que la variable de salida es la potencia del láser (P). No obstante, la selección de variables no está limitada a variables cuantitativas, ya que es posible añadir variables cualitativas relevantes para enriquecer el modelo. Las predicciones de este modelo se muestran en Figura 5 y Figura 6.

|

|

(1) |

Figura 5. Predicción de potencia del modelo MPR. Corte a 400ºC.

Figura 6. Espacio de la predicción de potencia del modelo de MPR

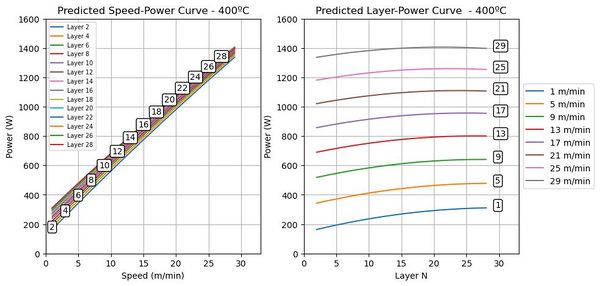

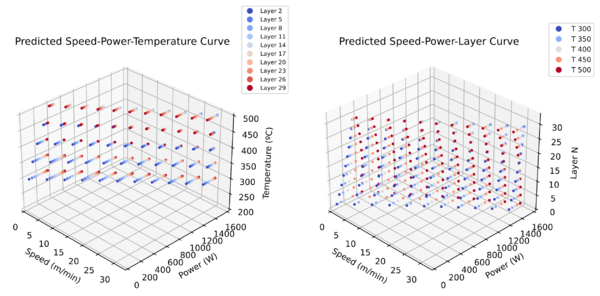

Por otro lado, las SVM son un conjunto de técnicas de aprendizaje supervisado que pueden usarse para la regresión y la clasificación. Las SVM son particularmente útiles cuando el espacio de las variables de entrada es de alta dimensión, y pueden capturar relaciones complejas y no lineales entre las variables de entrada y de salida (Figura 7, Figura 8).

Figura 7. Predicción de potencia del modelo SVM. Corte a 400ºC.

Figura 8. Espacio de la predicción de potencia del modelo de SVM

Se puede apreciar ligeras diferencias entre ambos modelos en el espacio de predicción de potencia. Su desempeño a la hora de estimar el comportamiento real del sistema se realizará en pruebas con datos reales y durante el control real de temperatura.

Ambos enfoques de modelado se implementaron utilizando librerías de software de código abierto [1]. Estas librerías ofrecen una serie de ventajas, como su flexibilidad y robustez, a la hora de filtrar y analizar datos, así como de generar modelos de aprendizaje automático.

Tras construir los modelos, se ha realizado una evaluación de ambos enfoques. Los resultados de esta evaluación se presentarán en el apartado 5.

5. Pruebas de los modelos de predicción

La evaluación de los modelos de predicción se realiza en dos etapas: pruebas en datos recopilados y pruebas bajo condiciones de control real.

En la primera etapa, se han probado los modelos en un conjunto de datos recopilados durante la operación de encintado. Durante la captura de estos datos, la potencia y la velocidad se ajustan manualmente para mantener la temperatura objetivo dentro de un rango aceptable, mientras que un controlador PID proporciona ajustes menores para mantenerse en temperatura de consigna.

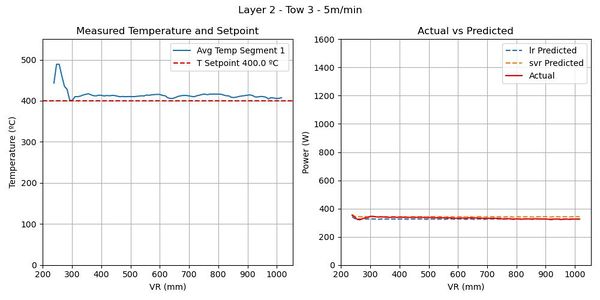

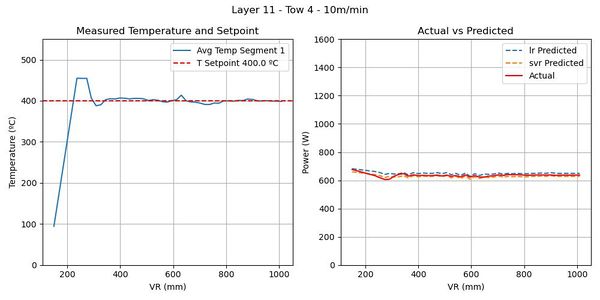

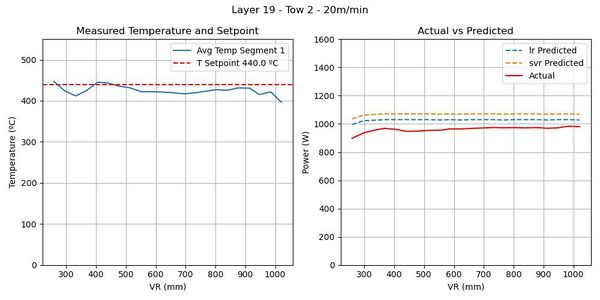

Se incluyen gráficos comparativos que muestran la temperatura de consigna y la temperatura media medida en la zona irradiada, así como la potencia predicha por los modelos en comparación con la potencia real utilizada durante la operación de encintado.

Los valores de salida de ambos modelos son muy similares en las condiciones en las que existe una mayor base de entrenamiento, a medias y bajas velocidades (Figura 9, Figura 10), y difieren más en condiciones de alta velocidad, para las que la cantidad de datos es menor (Figura 11).

Estos gráficos proporcionan una aproximación del rendimiento de los modelos en condiciones similares a las de funcionamiento real.

Figura 9. Predicción de potencia en encintado a 5 m/min y capa 2. Temperatura de consigna 400 º C.

Figura 10. Predicción de potencia en encintado a 10 m/min y capa 11. Temperatura de consigna 400 º C.

Figura 11. Predicción de potencia en encintado a 20 m/min y capa 19. Temperatura de consigna 440 º C.

La segunda etapa, que implica probar los modelos bajo condiciones de control real, está pendiente hasta la fecha. Esta etapa proporcionará información valiosa sobre cómo los modelos de predicción se desempeñan en la práctica y ayudará a identificar áreas para futuras mejoras. El objetivo es evitar el ajuste manual de la tabla de velocidad-potencia mediante el empleo de los modelos de predicción y realizar un ajuste fino con un control PID, evaluando así su capacidad para controlar el proceso de ISC de manera efectiva. Los resultados de estas pruebas se discutirán en futuros trabajos.

6. Conclusión

En resumen, este estudio destaca la utilidad de las técnicas de control basadas en datos para optimizar el proceso de ISC. La recopilación y análisis de datos, junto con la creación de modelos de predicción, ha proporcionado un entendimiento más profundo de las interacciones en el proceso. Se ha desarrollado un software adaptable que ofrece ajuste de control y adquisición de datos en tiempo real. Los modelos predictivos entrenados han mostrado su eficacia para predecir la potencia requerida para alcanzar una temperatura dada y abren la posibilidad de estudiar modelos más complejos que integren mayor número de variables, tanto cuantitativas como cualitativas. Aunque prometedores en pruebas sobre datos, su desempeño en control real está pendiente. Cabe destacar que este software y los modelos están diseñados para pruebas y caracterización, no para producción. Sin embargo, sientan las bases para futuras investigaciones y desarrollos en este campo.

Bibliografía

| [1] | F. Pedregosa, G. Varoquaux, A. Gramfort, V. Michel, B. Thirion, O. Grisel y otros., «Scikit-learn: Machine learning in Python,» Journal of Machine Learning Research, vol. 12, nº Oct, pp. 2825-2830, 2011. |

| [2] | G. James, D. Witten, T. Hastie y R. Tibshirani, An Introduction to Statistical Learning: with Applications in R, Springer, 2017. |

| [3] | S. Brunton y J. N. Kutz, Data-Driven Science and Engineering: Machine Learning, Dynamical Systems, and Control, Cambridge, UK: Cambridge Univ. Press, 2019. |

Document information

Published on 25/09/24

Accepted on 16/10/23

Submitted on 20/05/23

Volume 08 - COMUNICACIONES MATCOMP21 (2022) Y MATCOMP23 (2023), Issue Núm. 6 - Fabricación y Aplicaciones Industriales, 2024

DOI: 10.23967/r.matcomp.2024.06.07

Licence: Other

Share this document

Keywords

claim authorship

Are you one of the authors of this document?