1 Introducción

De acuerdo con [1], tradicionalmente se han modelado los problemas de ciencias, ingeniería, medioambiente y otras aplicaciones mediante modelos matemáticos deterministas que describen leyes naturales subyacentes. En la actualidad, se tiende cada vez más a incorporar algún tipo de incertidumbre para representar la falta de conocimiento sobre parámetros y datos físicos relevantes, variaciones aleatorias en las condiciones de operación o pura ignorancia sobre cómo debiera ser el modelo en realidad.

Suponga que se cuenta con observaciones tomadas en los tiempos , de un fenómeno representado por medio de un sistema de ecuaciones con la siguiente estructura:

|

|

(1) |

donde es el funcional de observaciones, es común por ejemplo tener y es la solución del siguiente sistema de ecuaciones diferenciales ordinarias, es decir; el regresor o el modelo directo (forward):

|

|

(2) |

Conociendo el verdadero valor de y las condiciones iniciales, resolver y conocer a se le llama un problema directo.

Sin embargo, en este caso el objetivo es hacer inferencia sobre a partir de las observaciones por eso se habla de un problema inverso [2].

Se puede considerar este problema como un mapeo:

|

|

este es el “mapeo del modelo directo”.

El mapeo inverso está, en general; mal planteado y no tiene mucho sentido:

|

|

por eso es necesario realizar una estrategia de regularización, como la cuantificación de la incertidumbre mediante inferencia bayesiana.

Para resolver el problema de inferencia dado en la ecuación (1) se propone que las entradas de sean variables aleatorias que siguen alguna distribución de probabilidad. Esto no necesariamente tiene un significado físico o intrínseco, sólo se sabe que se tiene incertidumbre acerca de los valores que pueden tomar estas variables aleatorias, y que la distribución de probabilidad cuantifica su incertidumbre. En este sentido, en el presente trabajo se aborda el problema de cuantificar la incertidumbre desde la perspectiva Bayesiana, en donde se obtiene la distribución a posteriori de los parámetros de interés.

2 Teoría Bayesiana

El trabajo de Thomas Bayes, publicado de manera póstuma en 1763, ha tenido una importante consecuencia en la forma de hacer inferencia estadística, este provee una manera formal de combinar el conocimiento a priori (o inicial) que se tiene sobre un fenómeno, con el nuevo conocimiento que se adquiere a partir de nuevos datos y mediciones sobre el mismo, obteniendo así un conocimiento a posteriori (o final). Es decir, el conocimiento a priori se actualiza con la nueva información, y dicho conocimiento a posteriori se convertirá en el nuevo conocimiento a priori, a la espera, otra vez, de nueva información que lo actualice. En este sección se utilizaron las siguientes bibliografías: [3], [4], [5], [6] y [7].

2.1 Distribución a priori y a posteriori

En estadística bayesiana, el término común para referirse a la información con la que cuenta el investigador es el de información subjetiva, y es importante aclarar, al menos brevemente, qué se entiende en este contexto por el adjetivo “subjetiva”, ya que puede tener una connotación distinta a la que se requiere bajo el enfoque bayesiano.

Al hablar de información subjetiva se refiere a toda aquella información a priori que se tiene en relación al fenómeno aleatorio de interés, antes de recolectar o realizar nuevas mediciones sobre el mismo, y esto incluye: datos históricos, teorías, opiniones y conjeturas de expertos, conclusiones basadas en estudios previos.

El primer paso en la inferencia estadística bayesiana es traducir todo lo anterior en una distribución de probabilidad a priori (o inicial). El segundo paso consiste en recolectar o realizar nuevas mediciones, y actualizar la distribución de probabilidad a priori, para obtener, mediante el teorema de Bayes, una distribución de probabilidad a posteriori (o final).

Será esta última la mejor descripción posible de la incertidumbre, de acuerdo a toda la información disponible, y por tanto, será la herramienta fundamental a partir de la cual se realiza inferencia estadística.

Para referirse a un modelo probabilístico paramétrico general se denota como , donde la función puede ser una función de masa de probabilidades de una variable (o vector) aleatoria discreta o bien una función de densidad de una variable aleatoria continua. El escribir dicha función condicional en el parámetro (o vector de parámetros) se debe al hecho de que, una vez dado un valor específico de , la función de probabilidad queda totalmente determinada.

Para referirse a una muestra aleatoria (m.a.) se utilizará la notación y para referirse a una observación muestral se utilizará . Por espacio paramétrico se entenderá como el conjunto de todos los valores que puede tomar , y por familia paramétrica se entenderá como un conjunto .

Siguiendo a [7], la estadística bayesiana modela la incertidumbre que se tiene sobre probabilísticamente. Esto es, considere el valor de como una variable (o vector) aleatoria con una distribución de probabilidad a priori (o inicial) , de la misma forma se denotará solo como , sin importar si es una variable aleatoria discreta o continua. Se trata de una distribución basada en experiencia previa (experiencia de especialistas, datos históricos, etc.) antes de obtener datos. Luego se procede a observar los nuevos datos (obtención de la muestra) y combina esta información con la distribución a priori mediante el teorema de Bayes y se obtiene una distribución de probabilidad a posteriori (o final):

|

|

(3) |

Note que es también una distribución de probabilidad de , pero a diferencia de la distribución a priori toma en cuenta tanto la información contemplada en como la información contenida en los datos observados . La distribución a posteriori de la variable aleatoria es la base para hacer inferencias sobre .

Tenga presente que, por un lado, la función de verosimilitud y son distribuciones de probabilidad, y por otro:

|

|

es la probabilidad (o densidad) conjunta de la muestra observada a partir del vector aleatorio . Pero hay que estar consciente de que es constante respecto a , por lo que se puede escribir:

|

|

(4) |

note que , es la probabilidad conjunta de la muestra condicional en , llamada función de verosimilitud, denotada también por . En el caso particular de que los componentes del vector aleatorio resulten ser independientes, se tiene que:

|

|

Puede proponer como estimador puntual de alguna medida de tendencia central, por ejemplo la mediana o la esperanza:

|

|

(5) |

Y aún en el caso de que no se cuente con información muestral se puede calcular utilizando en lugar de .

En algunos casos en los que, en vez de conocer el vector de parámetros , lo que interesa es describir el comportamiento de observaciones futuras del fenómeno aleatorio en cuestión, esto es, hacer predicción.

Dado un valor de , la distribución que describe el comportamiento de la observación futura es . El problema es que por lo general el valor de es desconocido. Por lo regular, la estadística frecuentista aborda este problema estimando puntualmente a con base en la muestra observada, y dicho estimador es sustituido en . Desde la perspectiva bayesiana, el modelo junto con la distribución a priori inducen una distribución conjunta para el vector aleatorio mediante el concepto de probabilidad condicional:

|

|

Si se marginaliza la distribución de probabilidad conjunta anterior se obtiene:

|

|

De los dos resultados anteriores, se tiene:

|

|

(6) |

A se le denomina distribución predictiva a priori (o inicial) y describe el conocimiento acerca de una observación futura basado únicamente en la información contenida en . Nótese que no depende ya de .

Para hacer estimación por regiones, por ejemplo, si desea calcular la probabilidad de que el vector de parámetros pertenezca a una región :

|

|

o bien, dado un valor , se busca un tal que . Con frecuencia la solución para no es única. Cabe aclarar que si las regiones son subconjuntos de y que un caso particular de estas regiones son los intervalos. En este sentido, la estimación por regiones en estadística bayesiana es más general que la estimación por intervalos de la estadística frecuentista.

Una vez obtenida la muestra, el modelo y la distribución a posteriori inducen una distribución conjunta para condicional en los valores observados :

|

|

En lo anterior, se justifica por la independencia condicional de y dado . Si se marginaliza la distribución conjunta condicional anterior:

|

|

Combinando los dos resultados anteriores:

|

|

(7) |

A se le llama distribución predictiva a posteriori (o final), y describe el conocimiento acerca de una observación futura basado tanto en la información contenida en como en la información muestral . Nótese nuevamente que no depende de .

Así que para hacer predicción sobre observaciones futuras del fenómeno aleatorio que esté modelando se usa o bien , según sea el caso. Y de manera análoga a lo mencionado sobre inferencia bayesiana, una manera simple de hacer predicción puntual, por ejemplo, de una observación futura podría ser mediante alguna medida de tendencia central, como la mediana o la esperanza:

|

|

donde es el rango de la v.a. . También, una manera de calcular la probabilidad de que una observación futura se encuentre en un conjunto sería:

|

|

Las ecuaciones (3), (6) y (7) constituyen el modelo general de la estadística bayesiana. Cualquier problema estadístico tratado bajo el enfoque bayesiano implica la obtención y utilización de las distribuciones correspondientes.

3 Análisis bayesiano del problema inverso

Una vez conocidas algunas bases sobre probabilidad y estadística, estadística bayesiana, se puede realizar inferencia bayesiana para resolver problemas inversos. El caso particular que se abordará, será el del modelo de crecimiento logístico. Para el desarrollo de este capítulo se utilizaron las siguientes bibliografías: [8], [7], [9], [10] y [11].

3.1 Aproximación bayesiana a inferencia

Se considera un fenómeno representado por medio de un sistema de ecuaciones diferenciales ordinarias. Suponga que se cuenta con observaciones tomadas en los tiempos , con la siguiente estructura:

|

|

(8) |

Como se mencionó en la introducción, el objetivo es hacer inferencia sobre a partir de las observaciones. Para resolver el problema de inferencia (8) se propone que las entradas de sean variables aleatorias que siguen alguna distribución de probabilidad. La incertidumbre se cuantifica con una medida de probabilidad. El agente interesado en conocer el parámetro , establece una variable aleatoria con su densidad de probabilidad

|

|

Los valores que toma son los posibles valores para los parámetros, en este caso toma valores (). Esta medida de probabilidad cuantifica la incertidumbre que tiene el agente respecto a los posibles valores de los parámetros en el modelo, es la distribución a priori .

En presencia de datos , y suponiendo un modelo para la distribución conjunta:

|

|

para , donde . Al observar los datos , interesa inferir el valor de . La teoría bayesiana prescribe que calcular la distribución condicional de las incógnitas de interés dados los datos, se calcula utilizando el teorema de Bayes para variables aleatorias:

|

|

es la distribución a posteriori; además es la distribución a priori de y

|

|

|

|

es la constante de normalización, también llamada verosimilitud marginal.

En el caso en que el error de cada observación representa un ruido aditivo gaussiano, la función de verosimilitud es:

|

|

Note que, cada vez que se evalué debe resolverse a , lo cual se hace de forma aproximada por medio de un método numérico.

Como consecuencia, el sistema de ecuaciones diferenciales ordinarias se resuelve utilizando un método numérico y la inferencia se realiza, no en el modelo exacto anterior, sino en un modelo aproximado, a saber:

|

|

donde denota la solución aproximada proporcionada por el método numérico. La nueva verosimilitud derivada del modelo es:

|

|

Para calcular comúnmente se usan métodos tipo Monte Carlo vía cadenas de Markov (MCMC). Este cálculo a su vez va a estar afectado por la precisión del método numérico usado para calcular a

La distribución a posteriori numérica es:

|

|

donde es la distribución a priori en y

|

|

es la constante de normalización, también llamada verosimilitud marginal. Note que dado que no hay otra alternativa que utilizar la distribución a posteriori numérica, hay una necesidad real de comprender y controlar el error incurrido al trabajar con y la aproximada numéricamente

En el anexo A se menciona que un método numérico es de orden , si , es decir, con K una constante global que no depende de . [12] demuestran que bajo un tamaño de paso se garantiza que prácticamente no existe diferencia entre la distribución a posteriori teórica y la aproximada numéricamente Con lo cual se le da validez al análisis de inferencia que se realice a partir de la distribución a posteriori aproximada numéricamente.

Los métodos estadísticos tradicionales se centran en la estimación puntual. El estimador de máxima a posteriori (MAP) se considera como una versión regularizada del estimador de máxima verosimilitud o el estimador de mínimos cuadrados.

|

|

donde es constante respecto a . Si se supone que hay independencia entre las variables y se tiene que:

|

|

(9) |

Esta última ecuación se llamará objetivo, y se utilizará más adelante.

3.2 El modelo logístico

De acuerdo con [9,13], una población es un grupo de organismos vivos (plantas, animales, microorganismos, etc.) que está compuesto por individuos con un comportamiento dinámico similar. Las poblaciones cambian de tamaño (crecen o disminuyen) debido al nacimiento, muerte y migración.

La dinámica de poblaciones estudia las leyes que rigen los cambios de la población en el espacio y el tiempo. Se centra en cómo las poblaciones cambian con el tiempo. Además, una población se describe por su número de individuos.

En 1798, Thomas Robert Malthus, propuso su modelo bajo las siguientes hipótesis:

- La población es homogénea (todos los individuos son idénticos).

- El medio es homogéneo, es decir, las características físicas, biológicas, etcétera, son las mismas en el hábitat.

- No hay limitaciones ni de espacio ni de alimento para el crecimiento de la población (la tasa de cambio de la población en el tiempo es proporcional a la población en ese instante de tiempo).

- La población está aislada (no hay migración).

- Las tasas de natalidad y de mortalidad son constantes.

Denote por:

- el número de individuos en el tiempo ,

- la tasa de natalidad, y

- la tasa de mortalidad,

con y positivos, entonces, por las hipótesis dadas, se tiene el siguiente modelo:

|

|

o bien,

|

|

donde y se le conoce como tasa de crecimiento instantáneo o tasa de crecimiento per cápita.

Cuarenta años más tarde, en 1838, el matemático belga Pierre François Verhulst (1804-1849) modificó el modelo de Malthus, cambiando la hipótesis 3:

- Los recursos (alimentos o tamaño del medio) son finitos.

Con esta nueva hipótesis habrá competencias entre la misma especie, así Verhulst propuso el modelo de crecimiento logístico:

|

|

o bien,

|

|

(10) |

donde y se llama capacidad de carga.

Dada una condición inicial , la ecuación (10) tiene como solución:

|

|

(11) |

o bien,

|

|

A la ecuación (10) se le llama ecuación logística. A pesar de que el modelo de crecimiento logístico tiene a esta como solución explícita, se utilizará el programa odeint, que se encuentra en la paquetería scipy.integrate implementado en Python; pues realizarlo de esta manera podrá ser replicable para cualquier otro modelo no lineal al que se pueda solucionar con un método numérico.

3.3 Simulación estocástica y aplicación

De acuerdo con [8], las evaluaciones de incertidumbre también pueden adoptar la forma de intervalos o regiones de credibilidad, similares a los intervalos de confianza utilizados en la estadística clásica. En general, para realizar inferencias sobre las incógnitas en el modelo y finalmente responder preguntas relevantes de investigación, se debe ser capaces de analizar la distribución a posteriori.

Conforme a [14], aunque no es prudente intentar analizar directamente las propiedades de la distribución posterior, existen métodos indirectos que puede proporcionarnos información considerable. En lugar de pensar en la distribución posterior como una función, se puede utilizar el hecho de que es una distribución de probabilidad y, por lo tanto, puede analizarse mediante métodos estadísticos, siempre que exista una manera de obtener una muestra.

Para eso, se utilizará un método de Monte Carlo vía Cadenas de Markov (MCMC). Los métodos de MCMC representan un conjunto de algoritmos que permiten obtener muestras aleatorias de una determinada distribución de probabilidad objetivo, de la cual es difícil muestrear directamente. Estos métodos se basan en construir una cadena de Markov cuya distribución de equilibrio, es la distribución objetivo. De esta forma, los estados de la cadena de Markov después de que esta ha alcanzado el estado estacionario representan muestras de la distribución objetivo.

La principal ventaja de los métodos de Monte Carlo es que podemos muestrear de una medida de probabilidad solo conocida hasta una constante de normalización. La principal limitación de este enfoque es que los métodos de Monte Carlo se deterioran con el aumento de la dimensión del parámetro.

El algoritmo base para realizar MCMC, es el algoritmo Metropolis-Hasting, este tiene la siguiente estructura:

con .

|

|

Algoritmo. 1 Algoritmo Metropolis -Hasting |

En general, los métodos de MCMC son muy complejos, requiriendo una calibración cuidadosa por parte de un experto, tanto para optimizar la velocidad de convergencia , como para identificar cuanto tiempo debe simularse la cadena antes de extraer la muestra. Una solución a este problema es el uso de una biblioteca de Python escrita por [15], llamada el t-walk, disponible en http://www.cimat.mx/ jac/twalk/. El t-walk utiliza un tipo especial de algoritmo Metropolis-Hastings de propósito general que se ajusta automáticamente para muestrear de cualquier distribución cuando se le proporcionan las funciones de soporte y el logaritmo de la función objetivo, en este caso la ecuación (9). Para iniciar el MCMC se debe añadir la cantidad de muestras a obtener y dos puntos iniciales.

Simulando un conjunto de datos sintético con la ecuación (11), con el modelo de error , donde , y los siguientes parámetros:

|

|

Se consideran 26 observaciones en los tiempos distribuidos regularmente entre 0 y 10.

Para realizar la cuantificación de incertidumbre para esta simulación, se tiene:

|

|

donde y , además el modelo directo es,

|

|

|

|

donde Suponiendo independencia a priori sobre los parámetros y , las distribuciones a priori propuestas son:

|

|

|

|

|

|

dado que lo único que se “conoce” sobre estos parámetros es que son positivos, por esto se tomarán valores de la distribución gamma, la cual toma solo valores positivos.

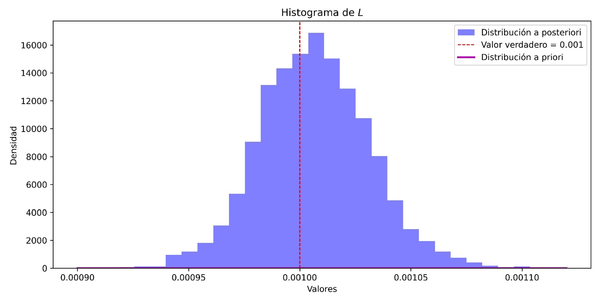

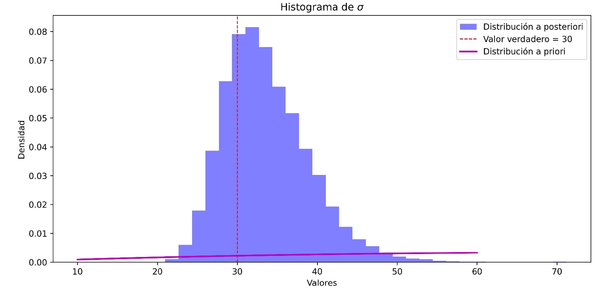

En las Figuras 1a, 1b y 1c, se tienen los histogramas de valores de la distribución a posteriori de y Se puede observar que el valor verdadero, con el que se realizó la simulación está dentro de la distribución a posteriori, además de estar cercano al punto con mayor credibilidad. Además, note que la distribución a priori queda muy por debajo de la distribución a posteriori.

|

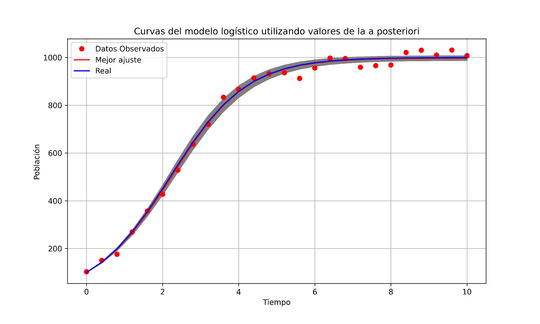

| Figura 2: Incertidumbre del ejemplo de simulación. |

En la Figura 2 se muestran los datos simulados, la solución del modelo logístico con los parámetros reales, la curva que mejor se ajusta la cual se forma utilizando los valores de mayor credibilidad en cada distribución a posteriori. Note que la curva con los parámetros reales y el mejor ajuste está una encima de la otra, salvo un pequeño error que es provocado por el error del método numérico. Por último, la parte sombreada son curvas solución a partir de valores de las distribución a posteriori para cada parámetro.

3.4 Aplicación: Saccharomyces cerevisiae

Las levaduras son hongos que forman sobre los medios de cultivo colonias pastosas, constituidas en su mayor parte por células aisladas que suelen ser esféricas, ovoideas, elipsoideas o alargadas. Los genetistas [16] realizaron un estudio para comparar la capacidad de sobrevivencia de cepas haploides, diploides y tetraploides de la levadura Saccharomyces cerevisiae al ser expuestas a mutaciones inducidas por metanosulfonato de etilo, evaluando las ventajas del enmascaramiento en niveles altos de ploidía, así como la eliminación de mutaciones en células haploides.

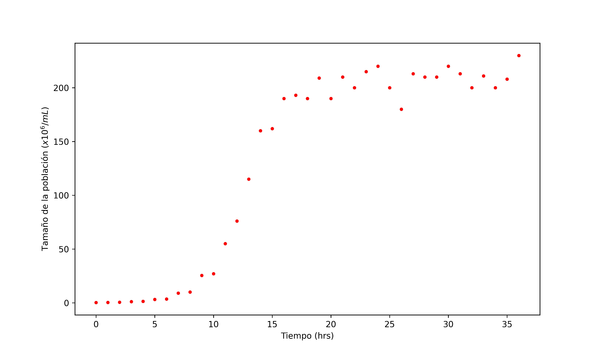

[9] recopilaron los datos del crecimiento de esta población de levaduras en diferentes horas, los datos se muestran en la Tabla 1.

| Tiempo | Tamaño | Tiempo | Tamaño |

| (hrs) | (/mL) | (hrs) | (/mL) |

| 0 | 0.200 | 19 | 209 |

| 1 | 0.330 | 20 | 190 |

| 2 | 0.500 | 21 | 210 |

| 3 | 1.10 | 22 | 200 |

| 4 | 1.40 | 23 | 215 |

| 5 | 3.10 | 24 | 220 |

| 6 | 3.50 | 25 | 200 |

| 7 | 9.00 | 26 | 180 |

| 8 | 10.0 | 27 | 213 |

| 9 | 25.4 | 28 | 210 |

| 10 | 27.0 | 29 | 210 |

| 11 | 55.0 | 30 | 220 |

| 12 | 76.0 | 31 | 213 |

| 13 | 115 | 32 | 200 |

| 14 | 160 | 33 | 211 |

| 15 | 162 | 34 | 200 |

| 16 | 190 | 35 | 208 |

| 17 | 193 | 36 | 230 |

| 18 | 190 |

En la figura 3a se puede observar el crecimiento de la levadura durante las primeras 36 horas, donde es claro observar que siguen el comportamiento de un modelo de crecimiento logístico donde su capacidad de carga llega aproximadamente a 250.

[9] sugieren el modelo logístico y muestran que las estimaciones de los parámetros son:

|

|

como los mejores para el ajuste de los datos al modelo. Cabe mencionar que no especifican el método utilizado para dichas estimaciones.

[17] presentó las siguientes estimaciones de los mismos parámetros calculados por mínimos cuadrados:

|

|

La figura 3b muestra la gráfica del crecimiento y la curva con los parámetros estimados en [17].

Usando estos datos, se realiza el procedimiento de cuantificación de la incertidumbre suponiendo el modelo de crecimiento logístico como el regresor. Este proceso se realiza de manera similar al ejemplo de simulación, es decir, se toman las mismas distribuciones a priori.

|

| Figura 4: Distribución a posteriori del parámetro , Saccharomyces cerevisiae. |

|

| Figura 5: Distribución a posteriori del parámetro , Saccharomyces cerevisiae. |

|

| Figura 6: Distribución a posteriori del parámetro , Saccharomyces cerevisiae. |

En las Figuras 4, 5 y 6, se tienen los histogramas de valores de la distribución a posteriori de y Se puede observar que los valores estimados por [9], [17] están dentro de la distribución a posteriori, además de estar cercanos al punto con mayor credibilidad, puede parecer que los valores estimados son los mismos pero se debe a la escala, estos si difieren un poco. Además, note que la distribución a priori queda muy por debajo de la distribución a posteriori. Por último, se puede ver la distribución a priori, donde hay un gran cambio entre la distribución a priori y la distribución a posteriori.

|

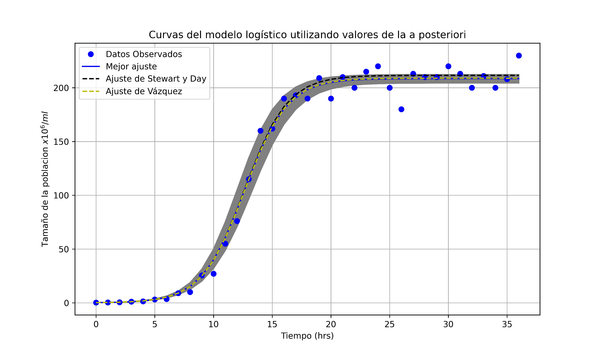

| Figura 7: Incertidumbre de Saccharomyces cerevisiae. |

En la Figura 7 se muestran los datos recopilados de la Tabla 1, la solución del modelo logístico con los parámetros de [17], [9] y la curva que mejor se ajusta, esta última se realizó utilizando los valores de mayor credibilidad en cada distribución a posteriori. Note que la curva con los parámetros dados por Vázquez se aleja un poco de las otras dos curvas, además la curva de mejor ajuste con la de Stewart y Day coinciden, por ese motivo se colocó de manera punteada, para distinguir entre cada una.

La Figura 7 es un ejemplo de una aplicación de la distribución a posteriori. Además, como se tiene varios valores de esta distribución se pueden encontrar valores de interés como las medidas de localización, medidas de variabilidad, coeficiente de asimetría y coeficiente de curtosis o algún otro cálculo dependiendo del interés del investigador.

El área sombreada se formó tomando curvas solución a partir de valores de las distribución a posteriori para cada parámetro. El uso de un área sombreada alrededor de los parámetros que mejor se ajustan en las gráficas de modelos es una técnica común en el análisis de datos. Esta área sombreada suele representar la incertidumbre o la variabilidad de los parámetros del modelo, en este caso, obtenida de la distribución a posteriori.

Esta área sombreada proporciona una visualización clara de la incertidumbre en las estimaciones de los parámetros del modelo. Muestra cómo varían las predicciones del modelo debido a la variabilidad en los datos. Esto es crucial en el enfoque bayesiano, donde la incertidumbre en los parámetros es una parte integral del análisis, por ejemplo, permite comunicar de manera efectiva la precisión y la confianza en las predicciones del modelo. El investigador puede ver, no sólo una línea de mejor ajuste, sino también cuánto pueden variar las predicciones. Esto es importante en contextos de toma de decisiones, donde entender la variabilidad puede influir en las decisiones basadas en los resultados del modelo. Además, facilita la comparación entre diferentes modelos o ajustes. Al superponer áreas sombreadas de diferentes modelos, se puede ver rápidamente cuál modelo proporciona predicciones más precisas o con menos incertidumbre.

Las áreas sombreadas pueden ayudar a identificar puntos de datos que se encuentran fuera de las predicciones esperadas, señalando posibles anomalías o la necesidad de ajustar el modelo. Por todo esto, es mejor optar en el futuro por resolver problemas inversos utilizando estadística bayesiana, no sólo usar métodos estadísticos y numéricos clasicos.

4 Conclusiones

El análisis de cuantificación de incertidumbre bayesiana de problemas inversos continua siendo un tema de investigación desafiante. El presente artículo es una introducción a realizar inferencia en el aspecto del análisis bayesiano de sistemas de ecuaciones diferenciales ordinarias en el contexto de problemas inversos, en particular el caso del modelo logístico.

Los problemas inversos surgen en una variedad de aplicaciones científicas y de las ingenierías, donde los parámetros del modelo deben ser estimados a partir de datos observacionales. Estos problemas se caracterizan por errores observacionales, errores de modelo y problemas de mal planteamiento que generan incertidumbres en los parámetros del modelo. Los enfoques estadísticos bayesianos permiten realizar simulaciones y predicciones con incertidumbres cuantificadas.

Se ha destacado la dificultad añadida que presentan estos problemas debido a la incapacidad de tratar analíticamente la función del regresor, lo que nos obliga a recurrir a aproximaciones numéricas. A pesar de que comúnmente se pasa por alto la sustitución de la solución teórica por una aproximación numérica. Se ha señalado el trabajo de investigación que [12] ha llevado sobre realizar inferencia sobre la distribución a posteriori númerica, en lugar de la téorica.

Como se mencionó, la distribución a posteriori puede tomar la forma de un área sombreada alrededor de los ajustes del modelo, esta área sombreada muestra la incertidumbre en las estimaciones de los parámetros del modelo. Muestra cómo varían las predicciones del modelo debido a la variabilidad en los datos. El investigador al resolver el problema inverso utilizando este método no solo obtiene los mejores parámetros que se ajustan, sino toda una distribución para ellos, lo que ayuda a ver cuánto pueden variar las predicciones.

Uno de los logros destacables de este trabajo es presentar de manera detallada un código realizado en Python, para la obtención de la distribución a posteriori para los parámetros de un modelo no lineal. Además, que el mismo genera histogramas de esta distribución, lo que ayuda a comprender a la misma y analogizar entre distribuciones más conocidas. Este código no lo muestran en trabajos del mismo tema, con este nivel de detalle. Los códigos se encuentran disponibles en https://github.com/RodGon22/RepositarioTesisRodrigo o escaneando el código QR de la Figura 8.

Por último, la aplicación como la que se mostró en la sección 3 ilustra cómo un enfoque probabilístico para codificar errores en el proceso de modelado puede conducir a simulaciones predictivas con medidas de incertidumbre confiables en problemas del mundo real. Sin embargo, aplicaciones más rigurosas conllevan más desafíos relacionados con la computación de alto rendimiento, alta dimensionalidad en datos y parámetros, predicción y otros que no se abordaron en este trabajo que se pueden considerar problemas a futuro.

|

| Figura 8: QR del repositario, generado con Google. |

BIBLIOGRAFÍA

[1] Carpio, Ana. (2023) "Incertidumbre y problemas inversos"

[2] Molina, Muñoz J. D. (2023) "Cuantificación de la Incertidumbre desde el enfoque bayesiano en el contexto de EDO"

[3] Lee, Peter M. (2009) "Bayesian statistics: an introduction. 3rd". Wiley, New York

[4] Bernardo, José M and Smith, Adrian FM. (2009) "Bayesian theory", Volume 405. John Wiley & Sons

[5] Mendoza, Manuel and Regueiro, Pedro. (2011) "Estadística Bayesiana". Instituto Teconológico de México

[6] Correa Morales, Juan Carlos and Barrera Causil, Carlos Javier. (2018) "Introducción a la estadística Bayesiana". Editorial ITM. Textos Académicos

[7] Erdely, Arturo and Gutiérrez-Peña, Eduardo. (2023) "Monografía de Estadística Bayesiana". arXiv preprint arXiv:2309.06601

[8] Christen, J Andrés. (2020) "Cuantificación de Incertidumbre bayesiana (Bayesian UQ)"

[9] Stewart, James and Day, Troy. (2015) "Biocalculus: Calculus for Life Sciences". Cengage Learning

[10] Kuschinski Kathmann, Nicolás Elio. (2014) "Improvements in Chronology Building from 14C Measurements using Bayesian Inference on Autoregressive Gamma Processes". CIMAT

[11] Torres, Maria Luisa Daza. (2018) "Numerical Solution of the Inverse Scattering Problem using High Level Representations"

[12] Capistran, Marcos and Christen, J. and Daza, Maria and Flores Arguedas, Hugo and Montesinos-López, J. (2021) "Error Control of the Numerical Posterior with Bayes Factors in Bayesian Uncertainty Quantification", Volume -1. Bayesian Analysis

[13] Iannelli, Mimmo and Pugliese, Andrea. (2015) "An introduction to mathematical population dynamics: along the trail of volterra and lotka", Volume 79. Springer

[14] Kuschinski Kathmann Nicolás Elio. (2014) "Improvements in Chronology Building from 14C Measurements using Bayesian Inference on Autoregressive Gamma Processes". CIMAT

[15] Christen, J Andrés and Fox, Colin. (2010) "A general purpose sampling algorithm for continuous distributions (the t-walk)"

[16] Mable, Barbara K and Otto, Sarah P. (2001) "Masking and purging mutations following EMS treatment in haploid, diploid and tetraploid yeast (Saccharomyces cerevisiae)", Volume 77. Cambridge University Press. Genetics Research 1 9–26

[17] Virgilio Vázquez. (2023) "Notas de modelación matemática". Universidad Tecnológica de la Mixteca

Document information

Published on 17/12/25

Submitted on 09/12/25

Licence: CC BY-NC-SA license