Abstract

El objetivo de este trabajo es presentar una metodología destinada a la obtención de información desde imágenes satelitales que se utilizará para la generación de mapas de usos del suelo y en simulaciones hidráulicas del área de estudio.

1. Introducción

El presente trabajo se ha desarrollado en el Centro Internacional de Métodos Numéricos en Ingeniería (CIMNE) en el marco del proyecto europeo RAMFLOOD DSS (RAMFLOOD Decision Support System). Ramflood tiene como objetivo crear un sistema de ayuda a la toma de decisiones para evaluar y gestionar escenarios de emergencias debidos a severas inundaciones en dos áreas de estudio, la zona del Bajo Llobregat (España) y la región de Ática (Grecia).

Ramflood combina datos ambientales y geofísicos a partir de observaciones satelitales, sistemas de posicionamiento, sensores in situ, información georeferenciada, un avanzado programa hidráulico de simulación y métodos gráficos de visualización.

La motivación del trabajo fue crear una metodología que sirva de guía para la obtención de información de usos del suelo, desde una imagen satelital, necesaria para la toma de decisiones de sistemas inteligentes y la simulación numérica de fenómenos naturales como son las inundaciones.

La metodología comienza con la obtención y corrección de las imágenes satelitales, siguiendo con el procesamiento de la información, y termina con la creación de mapas de usos del suelo (mapas temáticos).

Para finalizar el trabajo se ha realizado una implementación práctica de la metodología propuesta, donde además se ha simulado numéricamente una inundación en el área de estudio basándose en la información de usos del suelo que se generó a partir de la clasificación de imagen satelital.

Cuando hablamos de clasificación de las imágenes nos referimos al estudio de la información existente en cada píxel de las imágenes y a la posterior asignación de nuevos parámetros al píxel estudiado, como por ejemplo, cambiar el color existente en el píxel, o asociar un nuevo parámetro de rugosidad y condición inicial de agua, etc.

Resumiendo brevemente las partes componentes de trabajo podemos decir que comienza con la descripción de las generalidades de la teledetección y las imágenes satelitales, sigue por la presentación concreta de la metodología desarrollada y termina en la implementación práctica.

Se destaca la importancia de los resultados alcanzados y la extrapolación de los mismos a otras áreas que se vean favorecidas con las aportaciones de la teledetección espacial como fuente de información permanente y actualizada.

Una de estas áreas es la comprendida por los sistemas de ayuda a la toma de decisiones que necesitan predecir y proponer posibles soluciones las posibles situaciones de riesgos de inundación de las actuales zonas urbanizadas y en las futuras zonas donde se proyecte construir.

2. Objetivos

El objetivo de este trabajo es presentar una metodología destinada a la obtención de información desde imágenes satelitales que se utilizará para la generación de mapas de usos del suelo y en simulaciones hidráulicas del área de estudio.

A continuación se describen los lineamientos en los que se basa el estudio realizado:

- Procesamiento de imágenes satelitales.

- Clasificación de la información existente.

- Almacenamiento de los resultados de la clasificación.

- Representación de los resultados obtenidos a través de mapas temáticos (usos del suelo).

- Vinculación de la información obtenida en la simulación numérica del área de estudio (asignación de propiedades a cada elemento de la superficie).

Esta metodología está orientada principalmente al manejo de los datos satelitales y no a la forma en que son adquiridos.

3. Generalidades de las imágenes satelitales y la teledetección

3.1. Los fundamentos físicos de la teledetección espacial

Los fundamentos físicos de la teledetección espacial se basan en la medida de la radiación electromagnética emitida o reflejada por los objetos, como respuesta a la incidencia de una radiación natural (luz solar) o artificial (radar).

Si hablamos de radiación electromagnética natural nos referimos a teledetección pasiva y si hablamos de radiación electromagnética artificial nos referimos a teledetección activa.

Cualquier sistema de teledetección se compone de tres elementos básicos: el sensor, el objeto y un flujo energético electromagnético que permite realizar una asociación entre el objeto y el sensor.

Podemos definir a la teledetección espacial como la ciencia que describe las mediciones de propiedades físicas de los objetos obtenida a distancia desde un sensor.

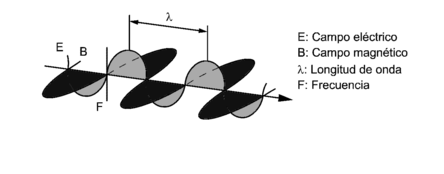

La energía electromagnética es una clase de energía que se transmite a través de ondas y resulta de la propagación simultánea en el espacio de un campo eléctrico (E) y un campo magnético (B) variables y por tratarse de una onda podemos asociar una longitud de onda () o frecuencia (F). Ver figura 3.1.

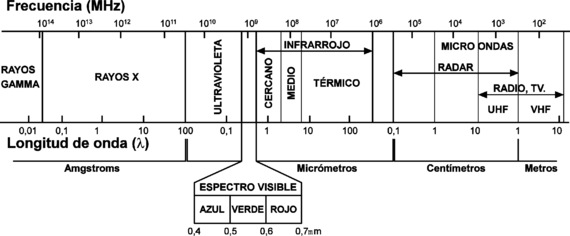

Esta energía puede ser clasificada por medio de las distintas longitudes de onda () o frecuencias (F) en lo que llamamos espectro electromagnético.

Recordar que la velocidad de propagación de una onda electromagnética en el vacío es de 300000 km/seg.

En la siguiente figura 3.2 podemos ver el espectro electromagnético dividido por rangos de variaciones de longitudes de ondas y los nombres que reciben estos rangos de ondas.

En teledetección, los procesos de medición se llevan a cabo dentro de los rangos de longitudes de onda llamados espectro visible, infrarrojo próximo, infrarrojo medio, infrarrojo lejano o térmico y microondas.

Espectro visible: comprende longitudes de onda entre los 0.4 y 0.7 µm y recibe su nombre por ser la única radiación electromagnética perceptible por el ojo humano. Se divide en tres bandas elementales que son: azul (0.4 - 0.5 µm), verde (0.5 - 0.6 µm ) y rojo (0.6 - 0.7µm ).

Infrarrojo próximo: comprende longitudes de onda entre los 0.7 y 1.3µm y se aplica principalmente para discriminar masas vegetales y concentraciones de humedad.

Infrarrojo medio: abarca longitudes de onda entre 1.3 y 8 µm y se utiliza para estimar contenido de humedad en la vegetación y detectar focos de elevada temperatura.

Infrarrojo lejano ó térmico: longitudes de onda entre 8 y 14 µm permitiendo la detección del calor procedente de la mayor parte de las cubiertas terrestres.

Microondas: longitudes de ondas mayores de 1mm. Resulta de gran interés por ser transparente a la cubierta nubosa.

3.2. Términos y unidades de medida

A continuación mencionaremos algunas definiciones y las unidades de medida asociadas a cada término.

Energía radiante (Q): se puede definir como energía radiante al total de la energía radiada en todas las direcciones y su unidad de medida es el Julio (J).

Flujo radiante (Φ): se puede definir flujo radiante al total de la energía radiada en todas las direcciones por unidad de tiempo. Se mide en Vatios (W).

Reflectividad (ρ): se puede definir como la relación entre el flujo incidente y el flujo reflejado por una superficie.

Absortividad (α): se puede definir como la relación entre el flujo incidente y el flujo que absorbe una superficie.

Transmisividad (t): se puede definir como la relación entre el flujo incidente y el flujo transmitido por una superficie.

3.3. El efecto de la atmósfera sobre la energía electromagnética.

Analicemos el proceso de propagación de las ondas electromagnéticas en el trayecto que une el objeto a estudiar y el sensor.

La atmósfera es el medio gaseoso a través del cual se producen las propagaciones de las ondas electromagnéticas provenientes del objeto hasta el sensor donde se determinará cuál es el valor de la longitud de dicha onda.

Muy distinto de un comportamiento de cuerpo transparente, la atmósfera introduce perturbaciones que alteran el estado original de las ondas.

Los efectos son muy variados y alteran las mediciones de la intensidad, frecuencia y distribución espectral de la radiación impuestas por la dispersión y la absorción atmosféricas. Ambas dependen de la altura de la capa atmosférica que debe atravesar la radiación antes de ser capturadas por los sensores, de su propia composición, de su propia composición, del contenido en partículas en suspensión y de las longitudes de onda en las que opere el sensor.

A continuación describiremos los efectos de dispersión y absorción atmosférica.

3.3.1. Dispersión atmosférica

La dispersión atmosférica se genera por la existencia en la atmósfera de partículas en suspensión y por moléculas de los propios componentes de ésta.

Este fenómeno produce sobre la radiación difusión en todas las direcciones.

Pueden distinguirse tres tipos:

Dispersión “Rayleigh”: Este tipo de dispersión se genera por partículas y moléculas existentes en la atmósfera que tienen un diámetro menor a la longitud de la onda electromagnética.

Dispersión “Mie”: Este tipo de dispersión se genera por partículas y moléculas existentes en la atmósfera que tienen un diámetro igual a la longitud de la onda electromagnética.

Dispersión “no selectiva”: Este tipo de dispersión se genera por partículas y moléculas existentes en la atmósfera que tienen un diámetro mayor a la longitud de la onda electromagnética.

Este efecto de dispersión decrece a medida que aumenta la longitud de onda.

3.3.2. Absorción atmosférica

Podemos decir que la absorción atmosférica se asocia a la retención de energía por parte de los deferentes componentes de la atmósfera.

Hay zonas del espectro electromagnético donde estos efectos de dispersión y absorción atmosféricos son de menor influencia. Estos rangos son el ultravioleta, el visible y el infrarrojo reflejado y térmico, además de las longitudes de ondas superiores a 1 mm., donde la transmisión atmosférica es total, siendo ésta una de las principales razones de su frecuente uso en teledetección. Por esta ventaja los principales sistemas de teledetección trabajan dentro de estos rangos del espectro electromagnético.

3.4. Relación entre el flujo incidente y el flujo reflejado

A continuación estudiaremos los distintos procesos que afectan a la energía electromagnética.

Pensemos en un haz de luz que incide sobre otro medio, puede darse el caso de que todo el haz de luz se refleje, o que se refleje y también se refracte.

En el análisis de una onda electromagnética podemos dividirlo en una parte para la reflexión de la onda y otra parte en la refracción de la onda.

Con la parte refractada podemos también realizar otra subdivisión, el que parte de la onda se absorbe y parte de la onda se transmite.

La energía absorbida posteriormente será emitida por el objeto pero dicha emisión será en otra longitud de onda.

Aplicando el principio de la conservación de la energía podemos decir que: el flujo incidente sobre una superficie es reflejado (), transmitido () o absorbido ().

Resulta conveniente expresar esta ecuación en términos relativos:

O, lo que es lo mismo:

En definitiva, la suma de reflectividad, absortividad y transmisividad tiene que ser igual a uno. La relación entre las tres magnitudes no es constante, sino que varía con la longitud de onda, por tanto en términos rigurosos se puede expresar la ecuación anterior de la siguiente forma:

Finalmente podemos afirmar que la proporción del flujo incidente que es reflejado, absorbido y transmitido depende de las características de la superficie que se observa y de la longitud de onda a la que sea observado. Entonces para poder caracterizar la respuesta de un determinado objeto tendremos que estudiar su respuesta para diversas longitudes de ondas.

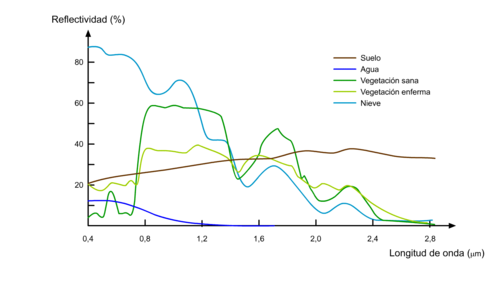

A partir de estudios de laboratorio se han podido obtener curvas que caracterizan la reflectividad espectral para las principales cubiertas presentes en la superficie terrestre.

Otro concepto que tenemos que definir es el de reflectividad o reflectancia.

La reflectividad es el porcentaje de energía reflejada respecto de la energía incidente.

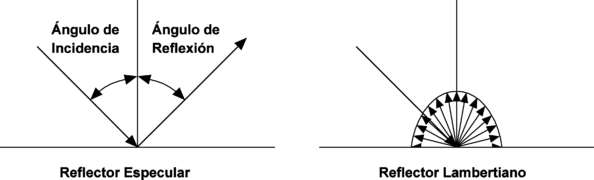

Esta característica de los distintos objetos depende de su naturaleza interna y la rugosidad de la superficie pudiendo clasificarse en dos tipos:

- Reflexión especular: Se genera cuando la onda incide sobre superficies lisas y planas. Este efecto se presenta cuando las variaciones altimétricas de la rugosidad superficial sean menores que la longitud de onda. En estos casos el ángulo de reflexión es igual al de incidencia.

- Reflexión difusa: Se genera cuando las variaciones de la rugosidad superficial son mayores que la longitud de onda. En este caso la energía es reflejada aproximadamente uniformemente en todas las direcciones. Cuando la superficie refleja la energía uniformemente, con independencia del ángulo de incidencia recibe el nombre de "superficie Lambertiana" (arena, nieve...), dependiendo la reflectancia sólo de la longitud de onda.

En la naturaleza prácticamente no encontramos objetos que tengan un comportamiento completo como reflector especular o lambertiano, presentándose una combinación de ambos, originándose grandes diferencias de reflectancia entre los objetos debido a la variabilidad de las texturas superficiales existentes y a la movilidad con que el relieve modifica el ángulo de incidencia.

Otra fuente de información importante de los distintos objetos es la relacionada con sus temperaturas y la podemos encontrar estudiando el sector del espectro denominado infrarrojo térmico.

Esta relación objeto-temperatura también puede ser utilizada para su identificación. Todo ello nos lleva al concepto de Emisividad (E) que es la proporción de energía emitida en relación con la energía incidente o, lo que es igual, la proporción entre la energía emitida por un objeto y la que emitiría un perfecto emisor, un "cuerpo negro", a su misma temperatura.

Finalmente, a partir del estudio del conjunto de valores característicos y propios de cada objeto podremos conocer su firma espectral, y esto nos ayudará a realizar gran parte de los procesos de interpretación de imágenes de satélite en el análisis y tratamiento de estos valores.

No hay que perder de vista que los distintos objetos pueden tener una respuesta espectral en función de su estado y relacionado con el entorno que lo rodea.

3.5. La adquisición de los datos. Sensores y plataformas

El paso siguiente es la adquisición de los datos de la zona de estudio.

Primeramente tenemos que definir cuál es el área de estudio. La manera de definir el polígono del cuál queremos conocer la información satelital es mediante las coordenadas de los vértices que lo componen. En el siguiente ejemplo podemos ver lo anteriormente enunciado

Coordenadas UTM

| Vértice | Coordenadas X | Coordenadas Y |

| A | 503360 | 4399921 |

| B | 504860 | 4399921 |

| C | 504860 | 4398621 |

| D | 503360 | 4398621 |

La adquisición de los datos se realiza mediante unos dispositivos llamados "sensores", que tienen la capacidad de poder capturar las distintas radiaciones electromagnéticas provenientes de los objetos situados en la superficie terrestre.

La información de la intensidad de las ondas electromagnéticas que arriba a los sensores es transformada en un valor "numérico" y posteriormente almacenada y/o transmitida a estaciones receptoras terrestres.

Del estudio de los datos en formato electrónico captados se pueden componer imágenes analógicas bidimensionales.

Dependiendo de las características y tipo de sensor utilizado se podrá tener calidades y precisiones muy distintas. Por estas razones en necesario definir previamente, dependiendo del grado de resolución y precisión deseado, sensor que debemos elegir de todos los sensores comerciales existentes montados en los satélites que cubren nuestra zona de estudio.

A modo de ejemplo aclaratorio, podríamos decir que no podemos pretender obtener un grado de detalle con una precisión de 1 metro si la mínima división de la imagen cubre un área cuadrada de 3 metros de lado.

A la mínima división de resolución la llamaremos píxel, y nos determina cual será el menor elemento a cubrir con total precisión, por tanto, un píxel es la menor división capaz de diferenciar un objeto de otro.

Finalmente podemos decir que un sensor es un instrumento que captura señales electromagnéticas que reflejan o emiten los objetos y la convierte en datos numéricos que pueden ser tratados posteriormente para su uso en los distintos campos de la ciencia. Ejemplos de esto son las imágenes satelitales utilizadas en áreas meteorológicas, en análisis ambientales como son el control de los bosques naturales, etc.

Al comenzar los fundamentos de la teledetección espacial dijimos que las radiaciones electromagnéticas emitidas o reflejadas por los objetos podían ser naturales o artificiales. Cabe aquí decir que los sensores se clasifican en sensores “pasivos” y sensores “activos”.

Los sensores pasivos son sensores que solamente son receptores de radiaciones electromagnética emitida o reflejada por los objetos, mientras que los activos son sensores que además de capturar las radiaciones electromagnéticas emitidas o reflejadas por los objetos están provistos por dispositivos que emiten señales que posteriormente son vueltas a captar por el sensor con la información de los objetos.

3.6. De los datos a la Información: El tratamiento y análisis de la imagen.

Posteriormente a la adquisición y almacenamiento de los datos en formato digital se procede a la transformación de éstos en información confiable. El nombre que recibe este tratamiento de la información es el de interpretación.

Cabe aclarar que dependiendo del tipo de sensor podemos tener datos en formato digital o analógico como es el caso de las fotografías.

Cuando tengamos datos analógicos la interpretación se realizará de forma visual usando criterios de textura, color, estructura, tono y observando la distribución física de los distintos objetos presentes en la imagen.

Cuando estudiemos datos digitales analizaremos las diferencias captadas de los distintos valores numéricos espectrales de los objetos.

Debido a la gran cantidad de información en formato digital es necesario hacer un primer procesamiento y convertir estos datos en imágenes explotables. Un inconveniente es la necesidad de disponer de equipos de la capacidad de trabajo suficiente para leer y manipular archivos de datos tan grandes. No olvidar que se tendrá un valor numérico por cada píxel leído.

En esta primera tarea se realiza simultáneamente una corrección de deformaciones o distorsiones que habitualmente presentan los datos originales.

Recordemos que estas distorsiones se generan cuando las radiaciones electromagnéticas atraviesan la atmósfera previa a llegar al sensor.

Una de estas operaciones se denomina corrección atmosférica y su aplicación exige conocer la composición de la atmósfera en el momento de la adquisición para corregir las distorsiones producidas que alteran los valores correctos de las radiaciones electromagnéticas de los objetos.

Otra operación de corrección de datos se asocia a las distorsiones que genera el propio sensor por defectos en el funcionamiento en el proceso de adquisición de datos.

Una parte importante de estas distorsiones geométricas están ligadas al funcionamiento del dispositivo de adquisición de los datos (scanner), a los cambios de altitud de la órbita o a la rotación relativa de la Tierra respecto a la órbita del satélite. La corrección de una gran parte de estas distorsiones o minimización de ellas se realiza mediante una programación de la velocidad del satélite de manera que se produzca una compensación de estos defectos.

Hay un grupo de deformaciones que se deben a la forma de lectura de la superficie terrestre por el sensor, se incluyen aquí desplazamientos unidireccionales o abatimiento del relieve o cualquier elemento vertical y aquellas producidas por la modificación del parámetro de vuelo.

Las primeras están directamente relacionadas con la altura del sensor, respecto al nivel de referencia y son, obviamente, importantes en los sensores aerotransportados. No obstante, al ser el abatimiento similar al producido en una fotografía aérea, (aunque, en este caso, se produce exclusivamente en el sentido perpendicular a la línea de vuelo y no de forma radial respecto al nadir de la fotografía) en las plataformas espaciales juega un papel importante a su favor la altura de la órbita (800 a 36000 Km.), presentando esta deformación valores insignificantes.

En el segundo caso, las deformaciones se deben a la inestabilidad de la plataforma aérea, ligada a su irregular desplazamiento por la siempre dinámica capa atmosférica. Obviamente, la estabilidad de las plataformas espaciales alejadas de las turbulencias atmosféricas es, en este sentido, significativamente mayor que en los aviones.

Sin embargo, las distorsiones antes nombradas (escala tangencial, movimientos de la plataforma, desplazamientos horizontales), pueden ser corregidas fácilmente para obtener productos de mayor fidelidad geométrica, sobre todo a nivel planimétrico.

Este conjunto de técnicas reciben el nombre de correcciones geométricas y su objetivo es aplicar a los datos originales una transformación tal que el espacio geográfico resultante sea perfectamente ajustable a una cartografía general de referencia.

Generalmente el proceso se basa en la elección de un conjunto de puntos de control homólogos en la imagen original y en el documento cartográfico utilizado, a partir de los cuales se obtienen las funciones de transformación polinómicas que permiten convertir el espacio geométrico de la imagen original en otro espacio igual al de la cartografía de referencia.

En este sentido, hay que decir que una corrección geométrica realizada sobre una imagen modifica los valores radiométricos originales y que, por consiguiente, la imagen resultante no podrá ser utilizada para establecer sobre ellas una clasificación de objetos en función de sus firmas espectrales.

3.7. La Visualización de las imágenes.

3.7.1. El color

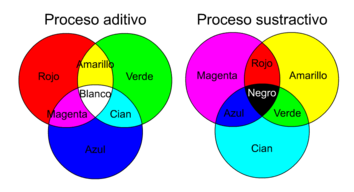

Independientemente de las bandas que se incluyan en la composición, conviene considerar algunos aspectos sobre el proceso que permite obtener esas composiciones en color. La mezcla de tres bandas espectrales en una composición en color puede conseguirse de acuerdo a dos procesos, denominados aditivo y sustractivo. En el proceso aditivo, cualquier color se obtiene por suma de los tres colores elementales o primarios: azul+verde+rojo. La suma de dos colores primarios permite lograr un color complementario: azul+verde=cian, azul+rojo=magenta, y verde+rojo=amarillo. Por el contrario, el proceso sustractivo se basa en la absorción de la luz que ejercen los colores complementarios: el cian absorbe la luz roja, el magenta absorbe el verde y el amarillo el azul. Los tres en combinación forman el negro.

El proceso aditivo es el usado en los sistemas electrónicos de visualización, como lo es un monitor de computadora. En cambio, el proceso sustractivo se emplea en la reproducción mecánica del color, por tanto, cuando se pretenda imprimir una imagen resulta preciso aplicar a cada banda uno de los colores complementarios.

En la figura Nº 3.6 se puede observar la formación del color por medio de los dos procesos anteriormente presentados.

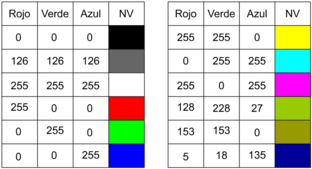

3.7.2. Tablas de referencia de color

Una tabla de referencia del color (Colour Look Up Table, CLUT), o simplemente tabla de color, es una matriz numérica que indica el nivel visual (NV) con el que se representará en pantalla cada uno de los niveles digitales (ND) de la imagen. La CLUT se inserta entre la memoria de refresco y el tubo de imagen del monitor, lo que permite modificar la relación entre el ND almacenado en disco y la intensidad de brillo con que se visualiza (NV). En consecuencia no tiene por qué existir una única equivalencia entre ND y NV.

En la mayoría de los equipos informáticos, la CLUT es una matriz numérica de 3 columnas por 256 filas. El orden de la fila indica el ND de entrada, mientras el almacenado en la tabla expresa el nivel de visual (NV), con el que ese ND será representado en pantalla. Las tres columnas corresponden a los tres colores elementales: rojo, verde y azul.

Conviene recordar que los equipos de tratamiento digital de imágenes utilizan el proceso aditivo de formación de color, por lo que cuanto mayor sean los valores de NV en cada columna, mayor componente de rojo, verde o azul tendrá el píxel finalmente visualizado.

Para el caso de trabajar con una sola banda de información de la imagen satelital, lo normal es que la imagen aparezca en pantalla en tonos de gris. Esto significa que cada ND tiene el mismo componente de rojo, verde y azul.

Si en cambio, trabajamos con tres bandas de información de la imagen satelital, de la combinación de los 3 niveles digitales de cada banda resultará una imagen en colores (combinación de rojo, verde y azul), pudiendo también presentarse píxeles con colores grises.

Por medio de unos ejemplos podremos aclarar mejor lo expuesto (ver figura 3.7).

3.7.3. Visualización de las imágenes

La plasmación gráfica de los resultados de cualquier tratamiento es la operación que nos permite reconstruir una imagen analógica con los datos digitales originales.

El proceso consiste en asignarle un tono de gris o un color a cada uno de los valores numéricos captados por el sensor. Para este fin, deben de construirse unas tablas de color en el ordenador, ya que no existe una relación tan evidente en el orden entre los colores como entre los diferentes tonos de grises e, incluso, esta relación puede ser modificada según las aplicaciones o el interés del usuario.

Habitualmente, las imágenes adquiridas recogen datos en varias longitudes de onda del espectro (bandas o canales) para cada píxel. Para visualizar esta información se procede a la asignación de colores a cada banda de información. Para ello se utilizan los siguientes colores: azul, verde y rojo.

Dentro de cada banda se establece un orden de asignación del color elegido según su tonalidad (de más claros a más oscuros).

Dependiendo de las bandas del espectro que el sensor pueda observar y de la composición de bandas que nos interese podremos tener imágenes en colores naturales, imágenes en falso color, o solamente monocromáticas.

En el caso que dispongamos información de las tres bandas del espectro visible y asignando el color azul a la banda 1, el color verde a la banda 2 y el color rojo a la banda 3 obtendremos imágenes en colores naturales (ver figura 3.8).

Si en cambio tenemos información de las bandas 2, 3 y 4, obtendremos imágenes en falso color. Habitualmente para este tipo de imagen se realiza la siguiente asignación de colores: el azul a la banda 2, el verde a la banda 3 y el rojo a la banda 4 (ver figura 3.9).

Otra imagen posible, también en falso color, es la que se obtiene de trabajar con las bandas 2, 4 y 5 ó 7, asignándose el color azul a la banda 2, el verde a la banda 4 y el rojo a la banda 5 ó 7. La siguiente figura 3.10 está compuesta por las bandas 2, 4 y 5.

A continuación se incluyen las figuras de cada una de las bandas usadas (1, 2, 3, 4 y 5) a partir de las cuales se obtuvieron las figuras en color natural y en falso color (ver figuras 3.11 a 3.15).

3.8. Las Técnicas de realce y transformaciones.

Existe un grupo de técnicas de tratamiento de imágenes cuyo objetivo es manipular las imágenes de forma que nos permitan extraer aspectos de la imagen que antes parecían ocultos.

Estas operaciones son denominadas técnicas de realce y son de gran ayuda en los procesos de interpretación, identificación visual de los resultados.

Podemos realizar una clasificación de estas técnicas de realce en dos clases o grupos.

El primero de los grupos se denomina píxel a píxel, en la que se mantiene el valor numérico de cada píxel original cuando la imagen es transformada, independientemente de su ubicación.

El otro grupo de técnicas tiene como objetivo poder ver las imágenes de forma diferente o distinta. En algunas de ellas se realizan un conjunto de operaciones de sustracción, adición, división o multiplicación con los diferentes valores de cada píxel para conseguir resaltar determinados aspectos de la imagen cuando se visualicen.

En este tipo de operaciones de realce el valor del píxel en la imagen transformada depende no exclusivamente de su propio valor en la imagen original, sino también, de los valores de los píxeles de su entorno próximo.

Dentro de este grupo podemos encontrar los denominados filtros que consisten en la aplicación de una transformación sobre la imagen original, obteniéndose una nueva imagen mejorada.

El valor digital de cada píxel es transformado por medio de una función matemática. En esta operación se relaciona el valor digital de cada píxel con los valores digitales de los píxeles de un cierto entorno en la imagen original.

Entre los más comunes se encuentran los denominados filtros de suavizado utilizados para eliminar el "ruido" de la imagen atenuando las altas frecuencias, siendo muy usados para la homogenización de áreas, haciendo desaparecer los píxeles aislados. Los filtros de realce permiten obtener una imagen de mayor calidad donde los contornos se realzan pero sin afectar excesivamente a las zonas homogéneas, facilitando la apreciación de más detalles que en la imagen original. Por último, los filtros de extracción de bordes provocan un cambio completo en la estructura de la imagen que resulta dominada por el "ruido". Son de gran utilidad para la extracción de contornos, límites, que aparecen realzados perdiéndose las zonas homogéneas.

Una de las técnicas más utilizadas en el tratamiento de imágenes es la del zoom, ya que los datos originales no tienen escala y es el tipo de restitución o visualización que se haga (el tipo de punto de la imagen, o el número de puntos asignados a cada píxel) lo que nos permite modificar las dimensiones de los productos analógicos.

Existen varios tipos de "zoom" entre los cuales el más sencillo es el directo, repitiendo un número de puntos (x2, x3) de imagen por cada valor del píxel original, sin embargo, desde la perspectiva visual, este proceso no es indefinido, ya que a partir de determinadas fases aparece el efecto del "cuadriculado" de la imagen.

4. Metodología utilizada

4.1. Introducción

A continuación se describirá la metodología a utilizar. Simplemente recordar que la motivación principal del trabajo se basó en desarrollar una metodología que sirva de guía para la obtención de información de usos del suelo, a partir de una imagen satelital.

Los lineamiento de la metodología comienzan por la obtención y corrección de las imágenes satelitales, continuando por el procesamiento de la información, y terminan con la creación de mapas de usos del suelo (mapas temáticos).

4.2. Metodología básica

4.2.1. Justificación del uso de la teledetección.

Para comenzar con la descripción de la metodología tenemos que decir que primeramente es necesaria la definición de los objetivos que se pretenden cumplir a través de la teledetección.

Por tanto, tendremos que realmente estar seguros que la teledetección nos solucionará al menos los interrogantes más importantes que esperamos responder trabajando con imágenes satelitales.

Planteamientos como los siguientes nos orientarán para aclarar estas cuestiones:

¿Qué problema de ingeniería u otra ciencia voy a estudiar?

¿Qué información pretendo obtener desde una imagen satelital?

¿Influye o no la época del año en que se adquieren las imágenes satelitales?

¿Qué precisión necesito para que sea significativa la observación?

¿Dispongo de imágenes actualmente?

Como se imaginarán éstas y otras tantas preguntas se necesitan plantear para la definición y justificación correcta del uso de la ciencia de la teledetección.

Actualmente existe una gran disponibilidad de imágenes satelitales de una gran parte de la superficie terrestre dado que hay una excelente cobertura por parte de satélites provistos con sensores para la adquisición de las imágenes.

4.2.2. Definición de la resolución espacial

Como mencionamos anteriormente uno de los puntos a definir previamente es la precisión necesaria que puede aportar una imagen satelital. Este es uno de los puntos más importante a la hora de elegir trabajar con un satélite u otro, dado que cada sensor puede aportar un cierto grado de precisión de imagen.

Recordemos que una imagen está formada por píxeles y un píxel es la menor división capaz de diferenciar un objeto de otro.

Al hablar de resolución espacial de los sensores estamos hablando del nivel de detalle que una imagen satelital nos ofrece.

La gama de resoluciones es muy variada, empezando por sensores con resoluciones de 1m x 1m para sensores de alta precisión hasta 5km x 5km que son sensores utilizados con fines meteorológicos.

Entonces si por ejemplo necesitamos contar con una precisión de 30m x 30m seleccionaremos un sensor que nos brinde por cada píxel la información de la observación de un polígono de 30m x 30m sin necesitar la correcta definición de los objetos que se presenten en el interior de dicho polígono.

A continuación se presentan algunas de las posibles elecciones de sensores disponibles a partir de los cuales podremos obtener las imágenes satelitales:

Ikonos (1m / 4m), IRS (5m Pancromático / 30m Multiespectral), Landsat 7 (15m/30m), Spot (10m) y datos rusos (1m ó 2m) por caso especial, y datos activos (todos los satélites anteriormente mencionados son pasivos o sea ópticos), incluyendo Radarsat y ERS para aplicaciones especializadas tales como la creación de DEMs (Modelos Digitales de Elevaciones).

4.2.3. Definición de la resolución espectral

Esta definición está directamente vinculada con los distintos objetos que forman parte de nuestro análisis.

Cada objeto tiene una capacidad de reflejar una cierta cantidad de energía electromagnética que lo define y lo diferencia de otros objetos. Por ejemplo, es muy distinta la respuesta electromagnética del agua presente en un lago de la respuesta electromagnética de la vegetación que lo rodea.

Cada cuerpo o material dependiendo en la zona del espectro que estemos estudiando tiene un cierto comportamiento característico que lo diferencia de otros materiales. Los estudios de las respuestas electromagnéticas se obtienen a través de estudios experimentales.

Recordar que el espectro electromagnético está compuesto por bandas definidas por su longitud de onda.

En teledetección es habitual trabajar con las bandas que cubren el espectro visible, el infrarrojo cercano, medio y térmico y microondas.

A partir del estudio de las distintas cubiertas y su comportamiento se puede seleccionar la banda o combinación de bandas que mejor representen o demuestren las características de los elementos componentes de la cubierta terrestre.

4.2.4. Definición de la resolución temporal

En este paso lo que se presenta es la posibilidad de discutir acerca del momento del año más conveniente o apropiado para la adquisición de la imagen satelital.

Por ejemplo, si lo que buscamos es cuantificar el uso del suelo de una zona agrícola para un estudio hidrológico de escurrimiento superficial de agua, debemos tener muy en claro que época del año vamos a estudiar por los ciclos de cultivos y la duración de los mismos. No es lo mismo tener una plantación de soja que una plantación de alfalfa.

Otro ejemplo es la determinación de parte de los componentes del suelo, para ello será apropiado planificar la adquisición de la imagen en épocas donde la vegetación tenga un desarrollo muy bajo o nulo.

4.2.5. Definición de la resolución radiométrica

Cuando hablamos de resolución radiométrica nos referimos a la capacidad que tienen los sensores en registrar variaciones en las distintas ondas electromagnéticas que arriban desde los objetos o cuerpos emisores.

El máximo número de variaciones capaces de registrarse recibe el nombre de resolución radiométrica.

Habitualmente la codificación digital se expresa la resolución en el número de bits que precisa cada elemento de la imagen para ser almacenado. En la actualidad lo normal para el rango de niveles de codificación que disponen los sensores varía entre 6 bits a 8 bits.

6 bits = 64 niveles de colores, 26 = 64

7 bits = 128 niveles de colores, 27 = 128

8 bits = 256 niveles de colores, 28 = 256

Excepcionalmente el sensor NOAA-AVHRR trabaja con 1024 niveles digitales (10 bits).

Cabe aclarar que cuando se trabaja con análisis multiespectrales se estudian por ejemplo las bandas del espectro visible (B1, B2 y B3) y si la resolución radiométrica del sensor es de 8 bits al combinar las 3 bandas obtendríamos 16777216 colores posibles en la imagen (2563).

4.2.6. Determinación de la zona de estudio

La pregunta que debemos responder en este punto es la siguiente:

¿Cómo especifico la zona que quiero estudiar?

En este momento necesitamos especificarle a la empresa distribuidora de imágenes satelitales cuales son las coordenadas del polígono que conforman el área de estudio.

Una forma muy fácil de suministrar esta información es indicando las coordenadas de cada uno de los vértices del polígono, para ello se puede recurrir al sistema geodésico de coordenadas (latitud y longitud) o al sistema de coordenadas rectangulares (UTM).

Generalmente las empresas disponen de catálogos con imágenes satelitales clasificadas por escenas y por fechas de adquisición. Como recordarán los sensores están instalados sobre satélites y éstos recorren su órbita con una determinada frecuencia, por lo tanto no podemos disponer de una escena para cada instante de tiempo, sino que debemos tener presente los posibles pasos del satélite por nuestra zona de estudio.

La observación de la superficie terrestre está ordenada por una grilla o cuadrícula definida, por lo que puede suceder que la cobertura de la zona de estudio se produzca por una composición de varias imágenes satelitales.

4.2.7. Corrección de la imagen satelital

El paso siguiente a la adquisición de la imagen satelital es la corrección o disminución de los errores presente en la imagen.

Estas técnicas para la corrección y realce de una imagen satelital se presentaron en los apartados 3.5 y 3.6. Recordando que las estas técnicas reciben el nombre de correcciones geométricas y técnicas de realce de las imágenes respectivamente.

El objetivo de las tareas de correcciones geométricas lo podemos describir como la acción de transformar una imagen sin una escala confiable a una imagen que sí represente información con una determinada escala real y segura.

Para ello es necesario la identificación y asignación de coordenadas confiables a una serie de puntos que nos servirán para escalar la imagen (puntos de control).

Esta información de estos puntos de control puede ser suministrada por los entes cartográficos de cada región o país, como por ejemplo los Instituto Cartográficos de cada País.

Existe otra posibilidad para realizar este ajuste de la imagen y es a través de trabajar con un modelo digital del terreno en donde podremos dar por buenos todos los puntos que existen sobre este modelo por lo que dispondremos de un número mayor de puntos que usaremos para el ajuste y la posterior verificación de la corrección.

Finalmente podemos decir que tenemos una imagen satelital de la zona de estudio confiable sobre la cual podremos trabajar correctamente.

Cabe aclarar que en la actualidad existen bancos de imágenes corregidas y a las que podríamos recurrir directamente sin tener que realizar ninguna corrección, o sea que existen imágenes satelitales confiables.

Cabe también mencionar que dependiendo del grado de precisión con que debamos trabajar o el objetivo del trabajo, sea necesario o no realizar corrección sobre las imágenes originales provenientes de los sensores.

Un ejemplo de esto lo podemos tener en una imagen meteorológica que puede tener sólo el fin de informar la existencia o no de nubes sobre una determinada zona de estudio.

4.2.8. Clasificación de la información

Básicamente dentro de este nuevo paso lo que nos debemos plantear es: ¿Cómo resuelvo la clasificación de la información presente en la imagen satelital?

¿Qué tipo de datos necesito obtener desde la imagen satelital?

¿Cómo almaceno esta información para su posterior utilización?

El planteamiento de la resolución de la clasificación de la información lo realizaremos a través de los siguientes seis pasos o pautas de trabajo:

1 – Definir qué información se clasificará.

2 – Conocer la respuesta electromagnética de los grupos de objetos que serán clasificados.

3 – Asociar los objetos a clasificar y sus respuestas espectrales.

4 – Realizar la clasificación de la imagen.

5 – Guardar la información obtenida.

6 – Verificar los resultados obtenidos.

1 – Definir qué información se clasificará

El objetivo de este primer paso está muy vinculado de los fines que llevaron a la definición de usar imágenes satelitales. Se busca la creación de grupos de objetos (entendiéndose por objeto a las distintas cubiertas del terreno) que representarán las distintas clases que utilizaremos para la clasificación la información de la imagen satelital.

Por ejemplo, si estamos analizando la costa de un río y el objeto de la imagen satelital era solamente poder determinar los bordes reales del área de inundación del cauce en épocas de crecida, las dos clases principales podrían ser agua y no agua, de nada nos servirá hacer una clasificación de vegetación o de cultivos.

Como se puede deducir no necesariamente una clase tiene que estar formada por objetos que tengan una respuesta electromagnética similar dentro de un determinado entorno.

2 – Conocer la respuesta electromagnética de los grupos de objetos que serán clasificados

Necesariamente para conocer la respuesta electromagnética de los distintos elementos que conforman un grupo o clase hay que realizar trabajos de experimentación ensayando muestras representativas (ver figura Nº 3.4).

Estos ensayos se pueden realizar en laboratorios o bien directamente sobre trabajos de campo. Cabe aclarar que cuando trabajamos en laboratorios es necesario simular el efecto del sol de la mejor manera posible ya que es el generador de las ondas electromagnéticas que reflejaran los distintos objetos y que serán adquiridas por los sensores.

3 – Asociar los objetos a clasificar y sus respuestas espectrales

Una vez determinada la respuesta electromagnética de los objetos se pasará a la fase de entrenamiento para la clasificación de la información contenida en la imagen.

Existen dos formas posibles de realizar esta clasificación: visual o digital.

Clasificación visual

Una de las principales ventajas del análisis visual sobre el digital es su capacidad para incorporar a la interpretación de la imagen criterios complejos. Mientras que el tratamiento digital se basa en la información radiométrica de cada píxel en las distintas bandas estudiadas.

Si realizáramos una clasificación visual el operario que realice el trabajo necesitará una fase previa de entrenamiento en donde se tendrá que familiarizar con los objetos a separar y su comportamiento espectral asociado, tratando de respetar algunos patrones propios para cada clase. Un ejemplo de esto podría ser el estudio del color de los distintos objetos en imágenes en colores o la tonalidad de grises en imágenes pancromáticas.

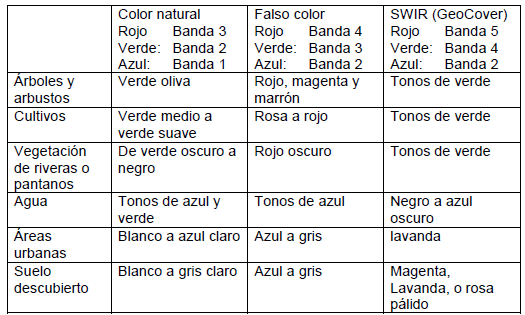

En la siguiente tabla podemos ver una lista que asocia posibles colores a objetos dependiendo de la combinación de bandas utilizadas (ver tabla 4.1).

Además del color en la clasificación visual intervienen otros criterios o elementos como ser el tono, la textura, el emplazamiento o disposición, el período de adquisición, etc.

La textura de la imagen procede de la relación entre el tamaño de los objetos y la resolución del sensor. Este efecto se manifiesta cuando tenemos un objeto que ocupa una superficie inferior a la menor unidad capaz de leer un sensor, o sea cuando el tamaño del objeto es menor que un píxel.

Si se quiere profundizar en el análisis de esta característica tenemos que estudiar, además del tamaño del elemento, el ángulo de observación del sensor (una observación muy aguda incrementan la rugosidad), las condiciones de iluminación (a ángulos solares muy bajos el efecto de sombras es más evidente), y la longitud de onda (una superficie lisa a longitudes largas puede aparecer como rugosa en cortas).

Cuando estudiamos el emplazamiento o la disposición de los objetos para ser clasificados lo hacemos en función de los objetos vecinos existentes en la imagen. Muchas veces se presenta la situación de que en la imagen tenemos tonos y colores similares tanto en zonas urbanas como en zonas rurales, y como es posible diferenciar claramente los límites de una zona u otra, podremos asignar un objeto que tiene un comportamiento similar a clases diferentes. Como ejemplo podemos mencionar la clasificación que se tendría que realizar con un jardín urbano que tiene la misma respuesta espectral que un área rural cultivada, pero claro está que una pertenece a una zona verde dentro de una urbanización y la otra a una zona de cultivos rurales.

Cuando no referimos al período de adquisición tenemos que tener presentes que algunas cubiertas vegetales tienen un comportamiento espectral diferente en épocas estivales e invernales. Entonces habrá que tener presente los posibles objetos y sus distintos comportamientos estacionales (multi-temporal).

Otros posibles criterios, pero con menor importancia, son el estudio de las sombras, los patrones espaciales, el contorno de las formas y el estudio del tamaño.

Clasificación digital

Si por el contrario utilizamos una clasificación digital, es necesario realizar un entrenamiento del sistema informático para la clasificación mediante la asignación de entornos de trabajo de los distintos grupos o clases. Concretamente se le tendrá que especificar la orden de clasificar en las distintas clases elegidas de acuerdo con el número digital que almacene para cada píxel. Para ello es necesario especificar un rango de valores posibles (información de cada píxel) para cada clase de objeto y para cada banda a estudiar.

Este objetivo se logra seleccionando una muestra de la imagen que represente a las distintas clases de objetos de la clasificación. A partir de esos píxeles se puede calcular los ND medios y la variabilidad numérica de cada categoría en todas las bandas que intervienen en la clasificación.

Tradicionalmente se han dividido los métodos de clasificación en dos grupos: supervisado y no supervisado, de acuerdo a la forma en que son obtenidas las estadísticas de entrenamiento. El método supervisado parte de un conocimiento previo del terreno, a partir del cual se seleccionan las muestras para cada una de las categorías. Por su parte, el método no supervisado busca automática los grupos de valores homogéneos dentro de la imagen, quedando para el operario la labor de encontrar las correspondencias entre esos grupos y sus categorías de asociadas.

El método supervisado es el método más utilizado y parte de un conocimiento de la zona de estudio adquirido por experiencias previas o trabajos de campo.

El área de estudio debe ser lo suficientemente representativa y homogénea de las clases que pretendemos definir. En general resulta conveniente seleccionar varias áreas por categoría, a fin de reflejar adecuadamente su variabilidad dentro de la imagen total.

Finalmente, con los programas (software) usados para hacer la clasificación se calculan las estadísticas elementales de cada categoría: media, rango, desviación típica, matriz de varianza-covarianza, etc., a partir de los ND de todos los píxeles incluidos en el área de entrenamiento asignadas a cada clase. Este cálculo se realiza para a todas las bandas que intervienen en la clasificación.

En oposición al método supervisado, el método no supervisado no implica ningún conocimiento del área de estudio.

Este método se centra en la definición de grupos de píxeles que tienen un comportamiento espectral homogéneo basándose en la agrupación según las clases temáticas de interés definidas.

El método para definir los agrupamientos espectrales es muy similar al empleado en otras técnicas de clasificación automática de datos (Johnston, 1978; Hand, 1981). Se basan en la selección de tres parámetros: variables que intervienen, criterio para medir la similitud o distancia entre casos, y criterio para agrupar los casos similares.

Como en el caso del método supervisado, es necesario analizar los píxeles incluidos en cada grupo para obtener sus medidas estadísticas elementales: media, desviación típica, mínimo, máximo, etc., que servirán para abordar la fase posterior de clasificación.

Dado que el método supervisado resulta muchas veces subjetivo, pudiendo el operario determinar erróneamente categorías sin valorar las características espectrales de la imagen, y el método no supervisado no garantiza que las clases deducidas tengan significado para el usuario de la clasificación (además de ser de difícil verificación), se han propuesto diversas alternativas que combinan ambos métodos y que son llamados métodos mixtos.

Un primer método mixto consiste en emplear el análisis supervisado para “guiar” al método no supervisado. Otra forma de orientar el análisis no supervisado es introducir los valores de los ND medios de cada clase de objetos calculados a partir de estudios supervisados.

De esta forma concluimos con la fase de asociación de objetos a clasificar y sus respuestas espectrales.

4 – Realizar la clasificación de la imagen

El paso que sigue es realizar la clasificación. En el caso de una clasificación visual un operario interpretará y separará en objetos por observación directa de la imagen del área de estudio (la imagen podrá estar impresa o en formato digital). Para la clasificación digital necesariamente tendremos que contar con un sistema que pueda interpretar la información digital de la imagen.

En la actualidad existen numerosos programas comerciales y educativos que nos permiten realizar esta clasificación. Esta clasificación se realizará según las distintas clases que el usuario defina.

5 – Guardar la información obtenida

El fin de esta tarea es guardar la clasificación realizada para su posterior análisis o procesamiento. Para ello existen dos posibles formas de trabajar, la primera se trata de almacenar la información en bases de datos y la segunda crear nuevas imágenes de la zona estudiada en forma de mapas temáticos.

Bases de datos

Hay una serie de pasos que es necesario definir antes de guardar información y es la estructura que tendrá la base de datos. Este punto que parece tan elemental no siempre se realiza y posteriormente aparecen las confusiones o equivocaciones cuando se trabaja o difunde la información extraída.

Mapas temáticos

Cuando se realiza una clasificación digital tenemos que recorrer toda la imagen analizando la información de cada uno de los píxeles y realizando la clasificación según las clases definidas. Si asignemos un color representativo a cada una de las clases, por ejemplo el color azul al agua, un color verde a los cultivos, etc., podremos ir generando píxel a píxel una nueva imagen que sea representativa de la clasificación realizada. A esta nueva imagen la llamamos un mapa temático.

6 – Verificar los resultados obtenidos

Como en todo trabajo, es necesario hacer una verificación de los resultados que se han obtenidos de la zona de estudio, independientemente del método de trabajo elegido.

Para hacer esta verificación planteamos las siguientes posibilidades:

Verificaciones visuales de las distintas clasificaciones.

Verificaciones de campo para comprobar la existencia de los distintos objetos o clases individualizadas.

Verificaciones de campo de las respuestas electromagnéticas de los distintos objetos clasificados.

Finalmente y a través de estas etapas básicas de trabajo, podremos tener la clasificación de la información existente en una imagen satelital.

4.2.9. Representación de la información

El paso siguiente a la clasificación y guardado de la información es la representación. Si al finalizar la clasificación representamos los datos por clases de objetos, tendremos información temática de la zona de estudio.

Esta representación es el primer nivel información obtenida a través de la teledetección.

La representación de la información finalmente la podríamos realizar tanto en forma digital o impresa, siendo hoy en día la representación digital la más poderosa de las dos formas de representación.

Hablemos de alguna de las tecnologías existentes para la representación digital:

Representación en formato raster

Representación en formato vector

Un archivo raster se compone sólo de información asociada a cada píxel independientemente de sus píxeles vecinos. Ejemplos de formatos de archivo raster: .BMP, .TIF, .JPG, .GIF, .PCX, .TGA, etc.

Un archivo vector se compone de gráficos basados en vectores, o sea geometría inteligente y vinculada a través de ecuaciones matemáticas con los píxeles vecinos.

Esta falta de inteligencia de las imágenes en formato raster no las descalificaría respecto a las imágenes en formato vector porque los fines o usos de cada tipo de formato son muy diferentes.

En un formato vector, por ejemplo, sería muy difícil enseñar toda la información de la imagen satelital en Internet (tardaría mucho tiempo en cargarse la información para la visualización en pantalla) y en cambio sí es posible incluir una imagen raster de tamaño reducido y con una calidad determinada.

La situación opuesta se presenta si se necesita trabajar necesariamente con imágenes vectoriales, ejemplo de ello sería la modelización de una superficie en 3D sobre la cual se pretende generar una vista lateral o cortes transversales según los planos coordenados de representación.

5. Descripción del caso práctico estudiado

A continuación se presenta la aplicación práctica de la metodología propuesta. El objetivo del ejercicio es poder obtener información acerca de los distintos usos del suelo (asociados a valores de rugosidades) del área de estudio, donde se pretende realizar una simulación numérica del comportamiento hidráulico.

La secuencia de trabajo para este caso práctico comienza con la especificación del área de estudio y finaliza con la representación de la información de los usos del suelo en la modelización de la superficie.

Para la modelización de la superficie de estudio se ha elegido trabajar con el programa GiD versión 7 (desarrollado por CIMNE). La simulación hidráulica se realizará con el software CARPA (desarrollado por la UPC).

Para la realización del trabajo se ha utilizado los lenguajes de programación: Visual Basic y Fortran.

5.1. Justificación del uso de la teledetección

La motivación para trabajar con imágenes satelitales era la necesidad de la definición de los distintos usos de suelo presentes en un sector de la superficie terrestre (área definida) donde se pretende realizar una simulación numérica que represente el comportamiento hidráulico, de acuerdo a una serie de parámetros de diseño.

Mediante el uso de la teledetección actualizaremos la información existente del uso del suelo y ampliaremos la información sobre zonas que hasta la actualidad no contaban con ella.

Otro punto importante a considerar en la elección de esta técnica, es la posibilidad de obtener información en diferentes épocas del año y por consiguiente la variación de los usos del suelo temporalmente.

Además, independientemente de los usos del suelo y si se realizara un seguimiento en el tiempo del área de estudio, se podría obtener información sobre las variaciones de las distintas zonas urbanizadas existentes.

5.2. Definición de la resolución espacial

Se eligió trabajar con uno de los satélites Indios (IRS), el IRS – D1, provisto con los sensores PAN y LISS – III.

La cámara o sensor PAN provee datos pancromáticos con una resolución de 5.8m y con un ancho de imagen de 70km.

El sensor LISS – III provee datos multiespectrales separados en 4 bandas. La resolución espacial para la los sectores del espectro visible (2 bandas, B2 y B3) y para el infrarrojo cercano (B4) es de 23.5m con un ancho de imagen que cubre 141km.

La cuarta banda, infrarrojo medio (B5), tiene una resolución de 70.5m y un ancho de imagen de 148km.

5.3. Definición de la resolución espectral

El sensor PAN provee datos de banda del espectro comprendido entre 0.5 – 0.75 micrones.

El sensor LISS – III provee datos multiespectrales separados en 4 bandas (B2, B3, B4 y B5). Cada una de las bandas cubrirá una porción del espectro determinado: B2 de 0.52 a 0.59 micrones, B3 de 0.62 a 0.68 micrones, B4 de 0.77 a 0.86 micrones, B5 de 1.55 a 1.70 micrones.

Como vemos dentro del espacio visible solamente tenemos cubierta las bandas del color verde (B2) y la banda del color rojo (B3) y no la banda del color azul (B1).

A partir de la combinación de los datos multiespectrales es posible matemáticamente obtener los aportes que produciría la B1 y de esta forma podemos obtener imágenes en colores reales.

5.4. Definición de la resolución temporal

El objetivo buscado en este caso práctico es poder hacer una clasificación de los usos del suelo del área de estudio. Para realizar este trabajo se cuenta con escenas de observación del área de 4 generadas en distintas fechas.

Se eligió trabajar con la observación de la zona más actual de todas.

Este criterio se fundamentó en la posibilidad de contemplar todos los últimos cambios hasta esa fecha.

5.5. Definición de la resolución radiométrica

Las imágenes que provienen desde los sensores montados sobre el satélite IRS representas adecuadamente los cambios de objetos o cuerpos emisores según el trabajo que se pretende realizar (8 bits, 256 niveles de colores por banda).

5.6. Especificación del área de estudio

Para la especificación del área de estudio prepararemos un gráfico representativo identificando los distintos vértices del polígono con sus coordenadas rectangulares (UTM).

Descripción del área de estudio

Coordenadas UTM

| Vértice | Coordenadas X | Coordenadas Y |

| A | 503360 | 4399921 |

| B | 504860 | 4399921 |

| C | 504860 | 4398621 |

| D | 503360 | 4398621 |

5.7. Corrección de la imagen satelital

Como planteamos cuando presentamos este punto, en la actualidad existen numerosas empresas distribuidoras de imágenes satelitales que las suministran perfectamente corregidas.

Por este motivo describiremos brevemente los pasos que se realizan para la corrección de las mismas.

Primeramente la empresa debe buscar la imagen o seguramente las distintas imágenes que proporcionan una total cobertura del área de estudio. Como recordarán, la adquisición de imágenes se realiza siguiendo una grilla de trabajo.

En la actualidad las empresas trabajan con entornos de trabajo que permiten la gestión de la información (GIS), un ejemplo de ello son los entornos de trabajo Arc View Shape.

En nuestro caso se trabajará con imágenes provenientes del sensor PAN que provee datos pancromáticos con una resolución de 5.8m y con datos provenientes del sensor LISS – III que provee datos multiespectrales separados en 4 bandas y con una resolución espacial de 23.5m para la los sectores del espectro visible (2 bandas, B2 y B3) y del infrarrojo cercano (B4).

A partir de las imágenes pancromáticas y multiespectrales, utilizando programas que interpretan la información se generan la información faltante de la banda 1. El resultado es una nueva imagen en colores reales con una precisión de 5m y en formato TIFF.

Recordar que el sensor no captura la información de B1 que corresponde al color azul y por este motivo hay que realizar una composición matemática de la información a partir del estudio de las otras bandas.

El paso siguiente es la ortorectificación de las imágenes, para esto es necesario la aportación de datos de puntos de control o de un modelo digital del terreno. Para poder realizar la corrección la empresa necesita contar con esta información topográfica en mapas con escala máxima de 1:25000 y de forma vectorial, el formato de archivo aceptado es: ArcView shape o GeoTIFF.

Después de la ortorectificación se realiza un balance radiométrico entre las distintas imágenes que cubren el área de estudio. Esto se realiza para equiparar información similar y que por ejemplo si tuviéramos un bosque que justamente es captado por el sensor en 2 imágenes no tengan distintos niveles de información radiométrica por tratarse de la misma especie de árboles.

Ahora con todas las imágenes corregidas y balanceadas se restituye el área de estudio, utilizándose todos los mosaicos del polígono de estudio.

Esta tarea tiene necesariamente que comenzar por elegir una primera imagen como inicio y continúa con el anexado de las imágenes vecinas sucesivamente.

Como la captación de las imágenes desde los sensores prevén estos trabajos de unión entre imágenes, en el momento de la adquisición se definen áreas de superposición entre imágenes. Entonces hay que elegir líneas de corte por donde pasarán las uniones entre imágenes vecinas.

El resultado final será una gran imagen del polígono de estudio que tiene que ser verificado cuidadosamente dado que una mal unión entre imágenes nos determinará distorsiones de ubicación de objetos.

Finalmente estaremos en condiciones de poder dar por finalizada la tarea de corrección de la imagen satelital de nuestra área de estudio y pasar a la tarea de clasificación.

Aquí nos encontramos con el problema de que el tamaño del archivo de la imagen es muy grande y no lo vamos a poder transportar, motivo por el cual se tiene que recurrir a la partición de la imagen final en nuevos mosaicos con un tamaño adecuado para su almacenaje y traslado. Un ejemplo de esto sería tener que usar como medio de transporte CD de 650 MB.

El formato de los nuevos mosaicos es GeoTIFF.

Este formato está compuesto por dos partes bien definidas: una parte Geo y una parte TIFF.

La parte TIFF es uno de los formatos más difundido en el mundo de la generación de imágenes.

La parte Geo es compatible con todos los softwares de información geográfica. Agrega al archivo TIFF básico, información de geo-referencia del archivo de imagen (coordenadas de la esquina superior izquierda de la imagen, dimensión de los píxeles) y, eventualmente describe la proyección cartográfica y el sistema geográfico asociados.

Superado este problema podemos decir que pasamos a la tarea de clasificación de la información.

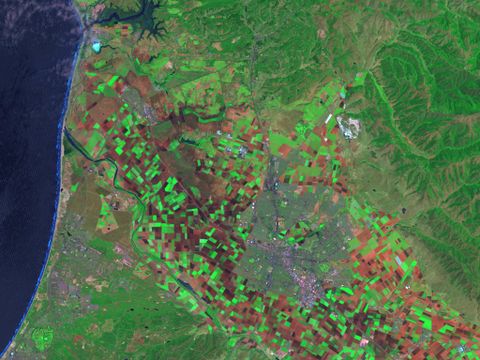

5.8. Clasificación de la información

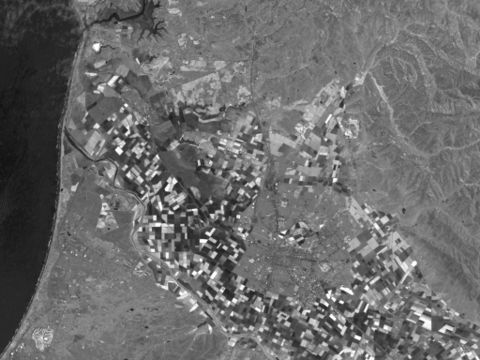

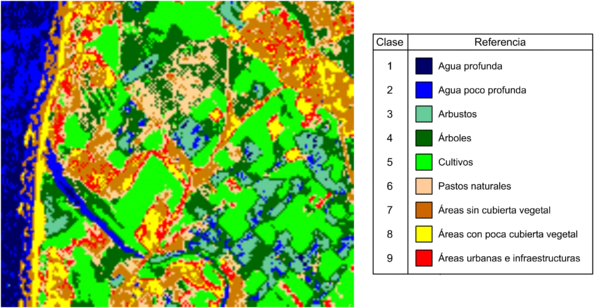

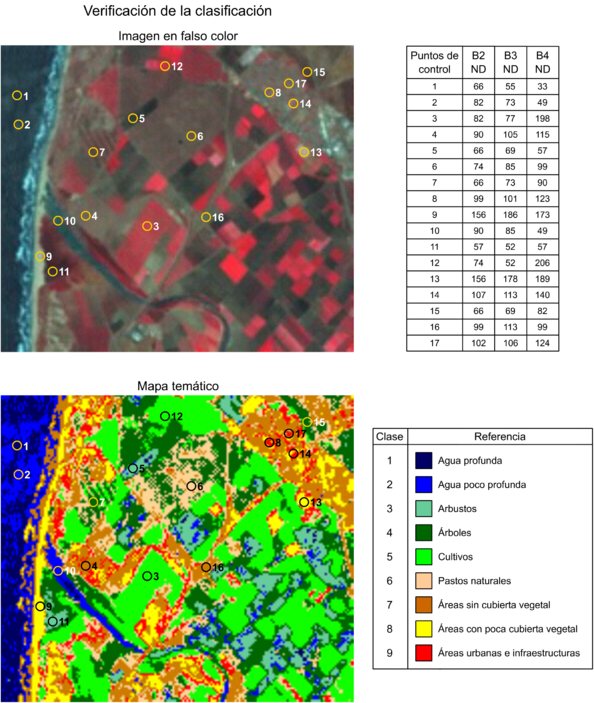

En esta etapa del caso práctico nos encontramos con una imagen satelital en falso color corregida (ver figura 5.1, bandas 2, 3 y 4), a partir de la cual trabajaremos solamente en nuestra zona de estudio según se puede observar en la figura 5.2.

Para el planteamiento de la resolución de la clasificación de la información habíamos propuesto realizar los siguientes seis pasos o pautas de trabajo:

1 – Definir qué información se clasificará.

2 – Conocer la respuesta electromagnética de los grupos de objetos que serán clasificados.

3 – Asociar los objetos a clasificar y sus respuestas espectrales.

4 – Realizar la clasificación de la imagen.

5 – Guardar la información obtenida.

6 – Verificar los resultados obtenidos.

A continuación se describe la forma en que se resolvieron los trabajos dentro de cada uno de los pasos.

1 – Definir qué información se clasificará

Dado que se necesita obtener datos sobre los usos del suelo del polígono de estudio que servirán de aporte para la simulación hidráulica de la zona, se decidió trabajar con las siguientes clases de objetos:

- Agua profunda

- Agua poco profunda

- Arbustos

- Árboles

- Cultivos

- Pastos naturales

- Áreas sin cubierta vegetal

- Áreas con poca cubierta vegetal

- Áreas urbanas e infraestructuras

2 – Conocer la respuesta electromagnética de los grupos de objetos que serán clasificados

La información sobre la respuesta electromagnética de cada uno de los grupos de objetos se recolectó a partir de trabajos de investigación en imágenes en satelitales en falso color y publicaciones que describen los distintos comportamientos de éstos dentro de cada una de las bandas del espectro electromagnético y también como respuesta de la combinación de varias bandas (B2-B3-B4, B1-B2-B3, PAN, etc.).

3 – Asociar los objetos a clasificar y sus respuestas espectrales

Dentro de esta etapa del trabajo es necesario hacer la asignación de los distintos niveles de información digital a las distintas clases de objeto que buscaremos, o sea realizar una tarea de entrenamiento.

Para cada una de las clases de objetos a clasificar se ha realizado un estudio estadístico de sus respuestas espectrales características, que servirán para clasificar los datos digitalmente según se describe a continuación:

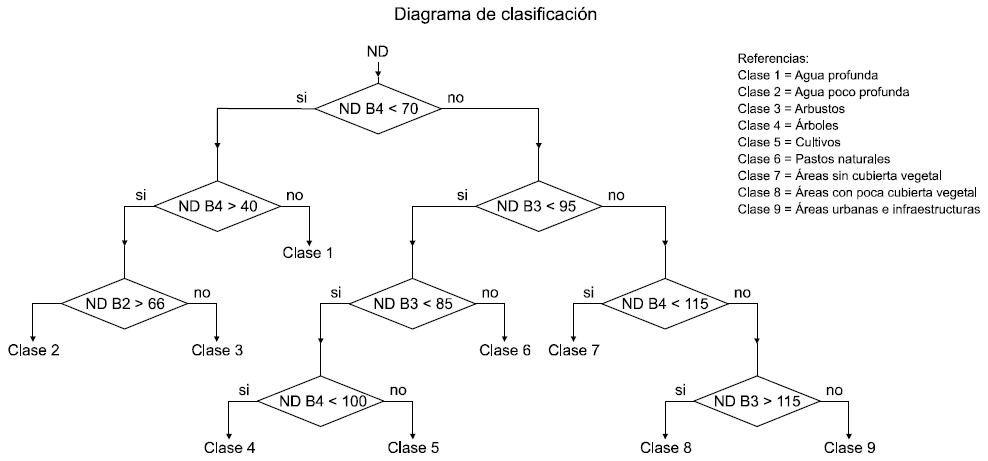

Finalmente se decidió clasificar la imagen en 9 clases de objetos:

- Clase 1 = Agua profunda (profundidad > 1m)

- Clase 2 = Agua poco profunda

- Clase 3 = Arbustos

- Clase 4 = Árboles

- Clase 5 = Cultivos

- Clase 6 = Pastos naturales

- Clase 7 = Áreas sin cubierta vegetal

- Clase 8 = Áreas con poca cubierta vegetal

- Clase 9 = Áreas urbanas e infraestructuras

En la siguiente figura se muestra el diagrama seguido para la clasificación (ver figura 5.3).

4 – Realizar la clasificación de la imagen

Para hacer la clasificación se realizó un programa que recorre la imagen píxel por píxel, interpreta la información de cada píxel, asigna una clase de objeto, y finalmente crea una nueva imagen en forma de mapa temático a partir de la imagen original.

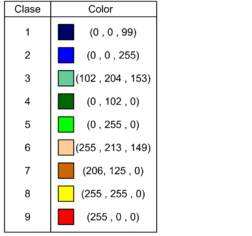

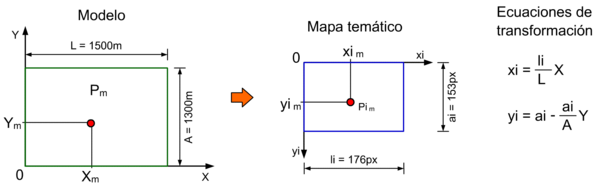

Se decidió la asignar los siguientes colores para la representación gráfica a cada clase:

5 – Guardar la información obtenida

Aprovechando la clasificación de cada píxel y asignando un color diferente a cada clase se ha guardado la información en una nueva imagen.

A continuación podremos observar la imagen del mapa temático resultante, ver figura 5.5

6 – Verificar los resultados obtenidos

Para la verificación de los resultados obtenidos se seleccionó una serie de puntos en de la imagen satelital (en falso color) y se realizó la clasificación a partir de los niveles digitales de información (B2, B3 y B4). En la figura 5.6 se pueden ver los puntos de control elegidos y los resultados obtenidos.

Analizando la imagen del mapa temático podemos ver que la clasificación no es perfecta y que existen pequeñas zonas con problemas. Si por ejemplo, miramos la zona de la playa (lateral izquierdo) podemos ver que el programa realiza la clasificación y asigna equivocadamente, a la zona donde se produce la rompiente de la ola, clases 7 y 8. También comentaremos como un punto a mejorar, la falta de continuidad las áreas urbanas e infraestructuras a partir de la mezcla con la clase 7 y 8.

Si además del estudio de la imagen en falso color (B2, B3 y B4) estudiáramos otra imagen en falso color (B2, B4 y B5) de la zona, podríamos comparar resultados de ambas clasificaciones obteniendo un grado de seguridad mayor cuando asignamos un clase.

Pero finalmente podemos decir que los resultados alcanzados en la clasificación son satisfactorios, demostrando claramente por medio de la representación de colores las distintas clases existentes.

5.9. Representación de la información

Finalmente restaría por modelizar la superficie del terreno y asociar información de los distintos usos del suelo y condiciones iniciales de altura de agua a partir de los datos del mapa temático del área de estudio

Recordar que el objetivo es preparar toda la información necesaria para el análisis hidráulico de la zona. Se dispone de programa de cálculo hidráulico CARPA creado por la UPC, el cual se ha integrado dentro de el pre y post procesador GiD desarrollado por CIMNE.

Información disponible de la zona de estudio

Se dispone de la siguiente información del área de estudio:

- Información topográfica

- Mapa temático

- Georeferencia de la imagen

Información topográfica

Se dispone de información topográfica realizada a partir de un relevamiento del terreno (coordenadas X, Y, Z de cada punto con un equiespaciamiento de 25m).

Cabe aclarar que esta grilla equiespaciada se obtiene a partir del procesamiento, de todos los puntos del relevamiento, con un programa informático topográfico que exporta la información siguiendo una grilla equiespaciada. Esta opción equiespaciada nos ayudará para la representación de la superficie.

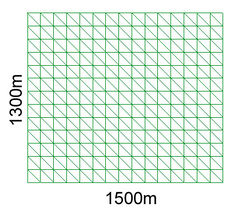

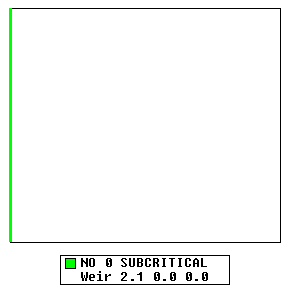

Dado que el objetivo del caso práctico es aplicar la metodología de análisis del la imagen satelital se trabajará con un equiespaciamiento mayor, x = y = 100m, y en una zona de estudio rectangular de 1500m de largo por 1300m de ancho.

La información topográfica se almacena en un archivo en formato TXT, con un ordenamiento por columnas (X, Y, Z) y por filas (una fila para cada punto de la grilla).

Mapa temático

Es la información generada a partir de la clasificación de la imagen. El formato de esta imagen es BMP y las dimensiones de la imagen son 176 píxeles de ancho y 153 píxeles de alto. La precisión de la imagen es aproximadamente 10m por cada lado de píxel (8.52m en dirección X y 8.49m en dirección Y).

Georeferencia de la imagen

Recordar que cuando trabajamos con una imagen satelital necesitamos tener información acerca de la ubicación de la zona representada, y esto lo conseguimos a partir de la información de referencia que acompaña a la imagen (Georeferencia).

La georeferencia nos define las coordenadas de la esquina superior izquierda de la imagen según un sistema de ejes coordenadas UTM y la dimensión de los píxeles.

Para nuestra imagen la georeferencia indica las coordenadas UTM:

X = 500000m

Y = 4394461m

Modelización de la superficie

Para la representación de la superficie de estudio se comenzó representando una superficie plana, (Z = 0), de dimensión 1500m por 1300m.

Después se creó una malla de triángulos estructuradas, definiendo el número de elementos por lado de la superficie, (15 elementos para la dirección X y 13 elementos para la dirección Y).

De esta forma se consiguió que las coordenadas X e Y de la malla de elementos coincidan con las coordenadas X e Y de la grilla topográfica, y la coordenada Z = 0.

Luego se realizó una traslación de la figura al origen del sistema coordenado. El vértice inferior izquierdo de la malla pasa a tener coordenadas (0, 0, 0).

En estos momentos en la etapa de modelización de la superficie del terreno sólo restaría por modificar la coordenada Z de cada vértice de los elementos de la malla a la coordenada topográfica correcta.

Si bien esta modificación de la coordenada Z se podría haber generado directamente moviendo cada uno de los puntos de los vértices de la malla en la dirección Z se optó por mecanizar esta tarea de la siguiente manera:

Primeramente se exportó la malla de elementos usando el comando “GiD mesh”.

Luego, se creó un programa que modificará las distintas coordenadas Z de la malla exportada. El programa va leyendo las distintas coordenadas X, Y de la malla del archivo exportado y busca esas mismas coordenadas en el archivo topográfico. De esta forma ubica cada vértice de la malla y le modifica la coordenada Z (originalmente Z = 0) según la coordenada topográfica real.

De esta forma tendremos la correcta ubicación de cada uno de los vértices de la malla obligándola a pasar por las coordenadas topográficas correctas.

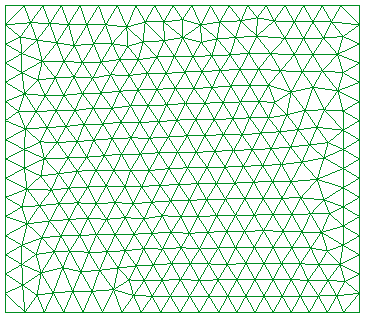

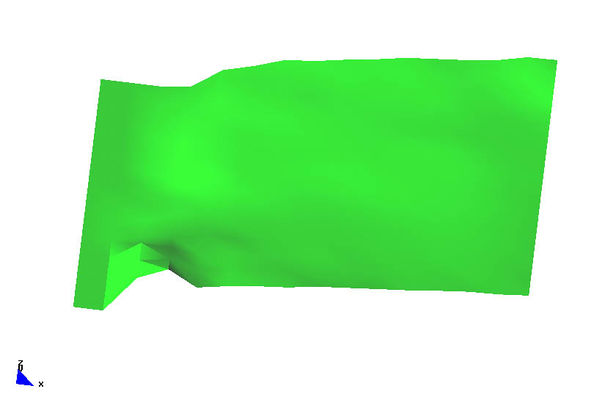

El paso siguiente fue abrir un nuevo archivo e importar la nueva superficie del terreno por medio del comando “Surface mesh”. A partir de esta superficie generamos una nueva malla de elementos triangulares, con una mejor densidad. La nueva malla tiene 380 nodos y 688 elementos, ver figura 5.8.

Finalmente en la figura 5.9 se puede observar la modelización del área de estudio. Para una mejor comprensión gráfica de la topografía se amplificaron cien veces las coordenadas Z (Z gráfico = 100Z reales).

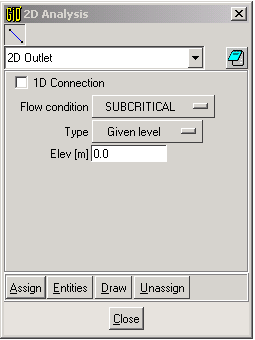

Luego de la representación de la superficie se realizó la definición del tipo de problema a resolver, eligiéndose trabajar con el problemtype Ramflood. Al elegir este tipo de problema, se activan las herramientas con las que podremos definir las condiciones de contorno (ingreso y egreso de agua), las condiciones iniciales del problema (altura de agua), la elección del tipo de simulación (1D ó 2D) y el tiempo de propagación de la onda de crecida la a considerar en la simulación.

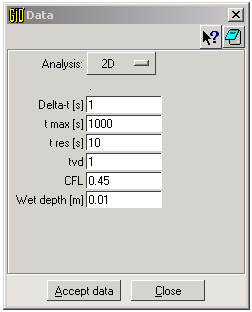

Elección del tipo de simulación y definición del tiempo de simulación

En la figura 5.10 se puede ver la elección del tipo de simulación y la definición del tiempo de simulación. Adoptándose un estudio en 2D y un tiempo de simulación de 1000 segundos.

Asignación de propiedades a los elementos

Para poder completar el preproceso es necesario asignar propiedades a los elemento de la malla, condiciones de contorno y condiciones iniciales.

En la asignación de propiedades se definen los distintos valores de rugosidades del los elementos por medio del coeficiente de Manning.

Para definir las condiciones de contorno, es necesario especificar zonas de ingreso y de egreso de agua de la malla.

Las condiciones iniciales especifican cual es la altura de agua inicial en cada uno de los elementos de la malla.

Para resolver la definición de las condiciones de contorno se definieron cuales son las zonas de ingreso y las zonas de egreso de la malla en estudio.

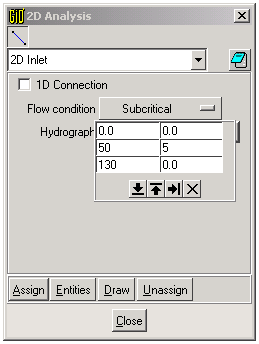

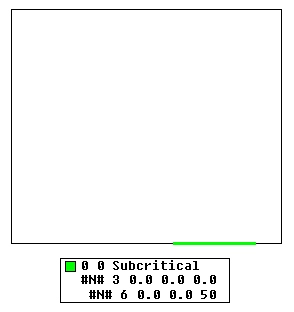

Se adoptó asignar en la zona de ingreso el histograma que se puede ver en la figura 5.11 y 5.12.

Para la zona de egreso de agua se decidió trabajar con vertedero, ver figura 5.13 y 5.14.

Como todavía no asignamos propiedades y de condiciones iniciales si quisiéramos al querer calcular la simulación el programa primero escribe los archivos que necesitará para el cálculo y después se ejecuta el programa de simulación.

Claro está que los valores de propiedades de rugosidad y de condiciones iniciales son igual a cero.

Previo a la ejecución del programa CARPA se intercaló un nuevo programa que completará la información faltante con datos extraídos directamente desde el mapa temático previamente generado. Esto quiere decir que completaremos la información del archivo de preproceso.

A cada elemento de la malla le asociaremos nuevas propiedades, para ello necesitaremos definir un punto característico de cada elemento al que se le asignarán los nuevos valores de rugosidad y de condición inicial.

Se ha optado por trabajar con un punto interior como el que se muestra en la figura 5.15

Para definir el punto interior de cada elemento se sigue la siguiente secuencia de trabajo:

Primero se trabaja sobre uno de los lados del triángulo y se ubican las coordenadas de su punto medio (P1), luego se trabaja sobre un segundo lado del elemento y se ubica nuevamente las coordenadas de su punto medio (P2). Finalmente se promedian las coordenadas de ambos puntos medios obtendremos un nuevo punto (Pm) que es interior al elemento al cual le asociaremos la propiedad de rugosidad y condición inicial del elemento.

Una vez definida la ubicación del punto interior el programa transforma las coordenadas del punto (Xm , Ym) en información de píxeles del mapa temático mediante la siguientes ecuaciones:

Una vez definido el píxel asociado al punto interior, se busca cuales son las propiedades de rugosidad (coeficiente de Manning) y condición inicial de altura de agua (m). Se adoptó trabajar con las siguientes propiedades para cada una de las clases de objetos, ver figura 5.17.

El paso siguiente es sobrescribir los valores rugosidad y de condición inicial para ese punto en el existente en el archivo (carpa2D.TXT).

Cuando se termina de reasignar valores en el archivo de preproceso comienza la ejecución del programa CARPA.

Finalmente, se pasa al estudio de los resultados en el post proceso.

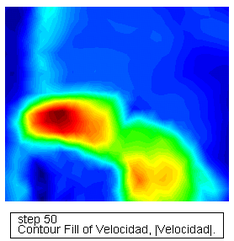

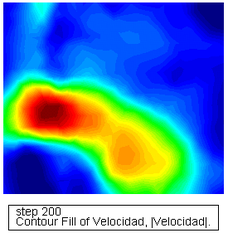

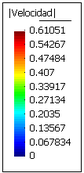

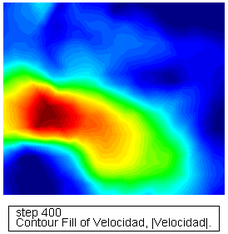

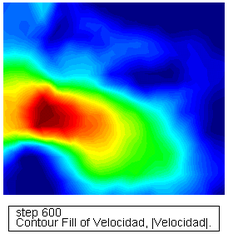

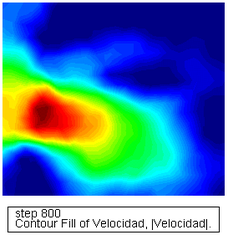

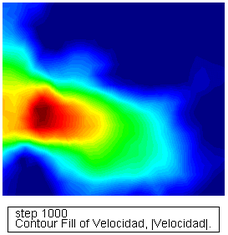

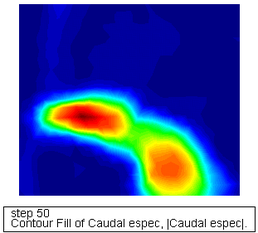

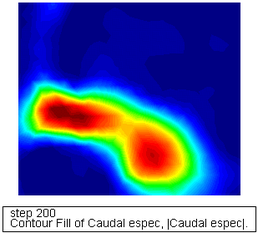

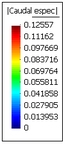

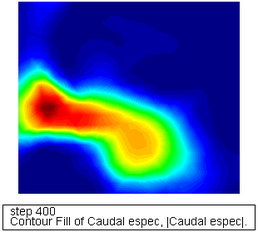

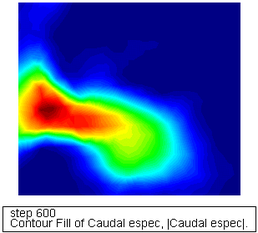

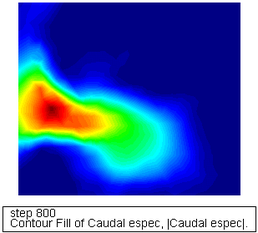

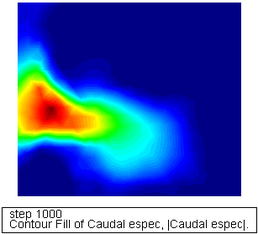

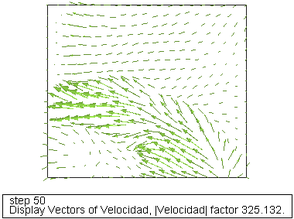

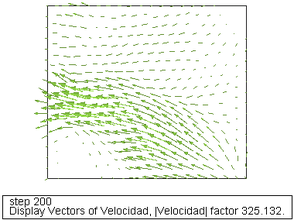

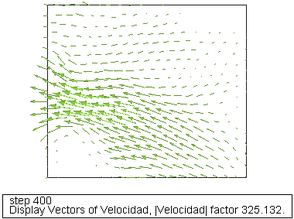

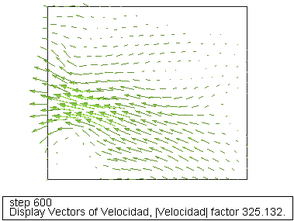

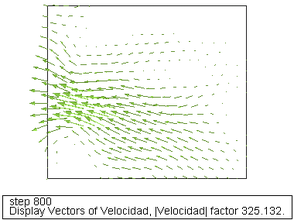

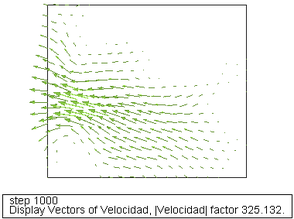

En la figura 5.18 podemos ver la variación de la velocidad, se presentan los siguientes pasos de tiempo: 50, 200, 400, 600, 800 y 1000 segundos de la simulación numérica.

En la figura podemos ver la propagación del agua desde la zona de ingreso hacia la zona de la desembocadura, con una velocidad máxima de 0.61 m/seg.

También se puede ver que se desborda el cauce, el área de inundación afectada y el tiempo de inundación.

En la figura 5.19 podemos ver la variación del caudal específico, en los distintos pasos de tiempo. El valor de caudal específico es de 0.126m2/seg.

En la figura 5.20 podemos ver la variación los vectores de velocidad las direcciones seguidas por el agua y los módulos de las velocidades, en los distintos pasos de tiempo.

Podemos concluir este apartado diciendo que cada una de las figuras anteriormente presentadas (figuras 5.18 a 5.19) podrían utilizarse como mapa de zonas de máximos de velocidades y caudales específicos respectivamente. Otra representación posible de obtener a partir de los vectores de velocidades son las líneas de corriente de flujo.

Estos mapas son de suma utilidad para el diseño, tanto actual como futuro, de posibles obras civiles a construir en las zonas aledañas al cauce.

Para poder obtener mejores resultados del comportamiento hidráulico del área de estudio habría que estudiar otras posibles condiciones de contorno y sobre todo mayores tiempos de simulación, determinando las condiciones críticas de la zona de estudio.

Pero este caso práctico tenía como objetivo implementar la metodología desarrollada y no hacer un estudio hidráulico detallado.

6. Conclusiones

A partir de los resultados obtenidos en el trabajo presentado, podemos decir que la principal conclusión es haber logrado desarrollar una metodología que nos permita obtener información desde una imagen satelital y al mismo tiempo aplicarla, tanto en la creación de información temática, como en la modelización numérica del comportamiento hidráulico de la zona de estudio.